デジタル表現の4つの特徴――ポスト・テクノ(ロジー)・ミュージック序論

久保田晃弘

この論考は、『ポスト・テクノ(ロジー)・ミュージック――拡散する〈音楽〉、解体する〈人間〉』(大村書店、2001年)に収録の同名の原稿に、著者による脚注と参考文献の大幅なアップデートを施したものです。2023年に刊行した同人誌『ferne ZWEI』の購入者特典として限定公開した記事を、このたび一般公開します。

はじめに

私は、形式と素材はひとつであり同一のものとみなされるべきだ、ということをあえて言明したいと思います。(中略)素材自体の内的本質に従って、最適な形式が決定されるのです。

――カールハインツ・シュトックハウゼン[1]

そこに潜在しているのは、音というものを一種の物質として捉えようとする、唯物論的な姿勢である。音楽とは作曲者=音楽家の内面でイメージされた音像をリプレゼントするものだという旧弊な思想は、完全に捨て去られている。

――佐々木敦[2]

「音域」(よりむずかしくいえば「周波数帯域(フリケンシー・エリア)」)という考え方。それは、ピアノの鍵盤の上では、一度も考えたことのない音楽の要素でした。

――山下邦彦[3]

[1]カールハインツ・シュトックハウゼン「電子音楽の四つの特徴」、『ユリイカ』1998年3月号(青土社)所収

[2]佐々木敦「テクノイズ・マテリアリズム――メタ=エレクトロニクス・ミュージック」、『InterCommunication No.26』(NTT出版、1998年)所収

https://www.ntticc.or.jp/pub/ic_mag/ic026/pdf/064-071.pdf

[3]山下邦彦『楕円とガイコツ――「小室哲哉の自意識」×「坂本龍一の無意識」』(太田出版、2000年)

ハードウェアの歴史

『ロック・マシーン・クロニクル』(原題は“Rock hardware”)という、ロック・ミュージックのハードウェア――すなわちギターやベースなどの楽器、PAシステム、レコーディング機器40年の歴史を、豊富な写真資料と共に紹介している本がある[4]。技術革新によって音楽がいかに変化してきたかを伝えるこの本の「シンセサイザー&ハイ・テック」(クリス・ジェンキンス著)という章には、エレクトロニック・ミュージックのハードウェアの歴史が、14ページに渡って綴られている[5]。

電話の開発の副産物として生まれた世界で初めての電子楽器である、エリシャ・グレイの音楽電信機(1876)。200トンもある誘電子交流発電機のサイン波を使った電話ネットワーク上の巨大加算合成シンセサイザーである、タデアス・カイルのテルハーモニウム(1897)[6]。ウイリアム・ダデルによる「歌うアーク灯」(1899)。非接触インターフェースと2つの発信器のうなりを利用した、テルミン(1917)。同じヘテロダイン方式による、オンド・マルトノ(1928)。ネオン管を利用したトラウトニウム(1930)[7]といった、初期の果敢な実験の産物の紹介で、この章は幕を開ける。

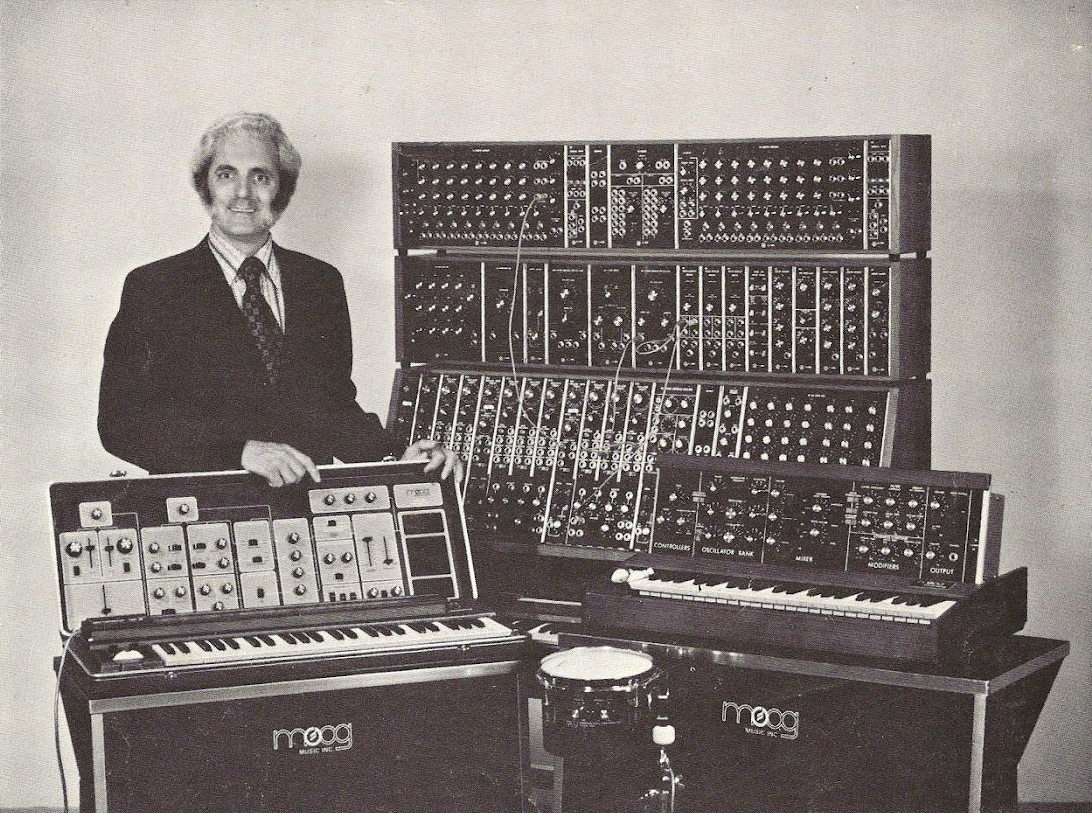

続いて、1964年にロバート・モーグ博士が製作したモーグ・モジュラー・システムによるアナログ・シンセサイザーの発明と、そのコンパクト化やポリフォニー化、シーケンサー/リズム・マシーンとシンセ・ベースの誕生と進化、さらにはシンセサイザーのデジタル化とMIDI(Musical Instrument Digital Interface)、FM(Frequency Modulation)合成やサンプリング音源といった、わずか40年足らずのめざましい電子楽器発展の歴史が、豊富な具体例と共に手際良く語られる[8]。

ビンテージ・マシンの復活とバーチャル・アナログ・シンセサイザー、ハイブリッドなワークステーション・キーボードの登場、そして物理モデリング・シンセサイザーの紹介でこの章は終わる。原本の出版年は1996年である。では、その1996年以降――つまりこの「シンセサイザー&ハイ・テック」の章のエンディングの後、エレクトロニック・ミュージックの歴史を代表するハードウェアとして登場したのは、一体どんなマシンだったのだろうか?

[4]ポール・トリンカ編/金子 みちる、川腰和歌子、江口達也訳『ロック・マシーン・クロニクル――ロック楽器の40年史』(シンコーミュージック、1999年)。原著は以下より閲覧できる。

https://archive.org/details/rockhardware40ye00tryn/

[5]オンラインで同様の内容が閲覧できるアーカイブサイトとして、「120 Years Of Electronic Music」がある。

https://120years.net/

[6]鍵盤の数だけ用意された発電機により正弦波を発生させ、その音を合成して電話で聴くという仕組みの電子楽器。「120 Years Of Electronic Music」の当該ページは以下。

https://120years.net/the-telharmonium-thaddeus-cahill-usa-1897/

[7]ヒッチコックの映画『鳥』の効果音は、この楽器の名手として知られたドイツの作曲家、オスカー・サラ(1910-2002)によって、鳥の鳴き声も含めすべてトラウトニウムによって制作されている。以下の動画ではその制作工程を辿りながら、それが20世紀、そして今日の音楽とテクノロジーの関係に、どのような影響を与えたかを考察している。

https://www.youtube.com/watch?v=UxINIwHxR8s

「120 Years Of Electronic Music」の当該ページは以下。

https://120years.net/the-trautoniumdr-freidrich-trautweingermany1930/

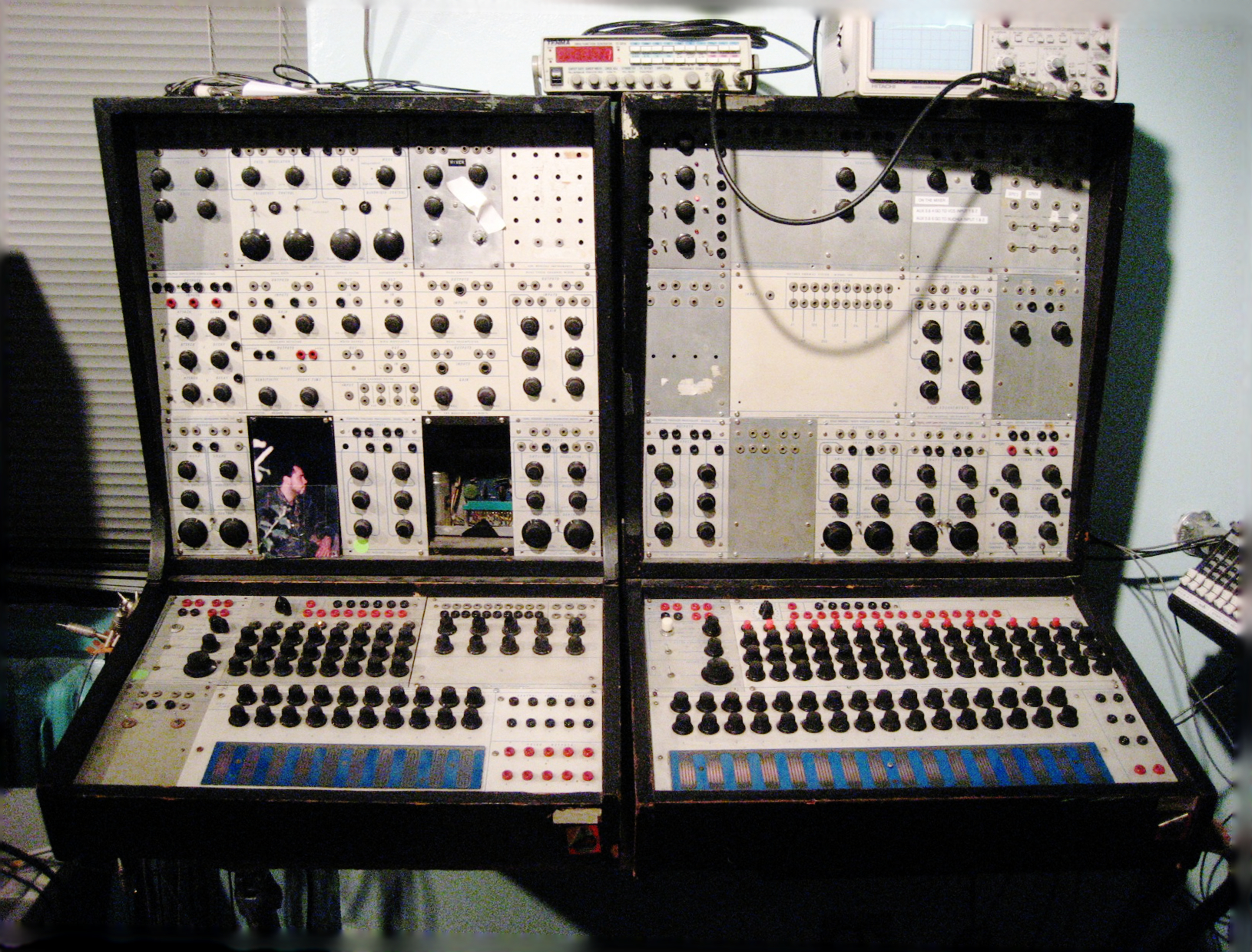

[8]初期のシンセサイザーがどのようなものだったかは下図を参照。いずれも、飛行機のコックピットのような巨大なパネルと、多数のジャック(パッチケーブル)やノブがついたビジュアルに圧倒される。

モーグ・シンセサイザー。「120 Years Of Electronic Music」の当該ページは以下。

https://120years.net/moog-synthesisersrobert-moogusa1963-2/

ブックラ・シンセサイザー。「120 Years Of Electronic Music」の当該ページは以下。

https://120years.net/buchla-synthesisersdonald-buchlausa1963/

リアルタイム・シンセシス革命

1998年に登場した「Macintosh PowerBook G3 Series」[9]は、1999年のアルス・エレクトロニカでデジタル・ミュージック部門賞を獲得したメゴ・レーベル[10]のピタや、ファーマーズ・マニュアル、クリスチャン・フェネス(フェネス)、電子音響の革命児マーカス・ポップ(オヴァル)といった、現代のイノベイティブなミュージシャンを特徴づけるハードウェアである。

彼らはこの、わずか3kg少々のハードウェアを片手にライブ・ツアーに出かけ、世界各地で演奏する。時にはPowerBookのアウトプットをマーシャル・アンプに接続し、またあるときは多数のPowerBookによるオーケストラを組織する。数年前までは、MIDI接続されたシンセサイザーやサンプラー、エフェクタを併用していたクリストフ・シャルル[11]やカール・ストーン[12]、ノイズ・ユニット、メルツバウの秋田昌美[13]、そしてプリペアド・ギターによるインプロヴィゼーションで知られるケヴィン・ドラムらも、このマシンの登場以後はPowerBookを中心にしたラップトップ・パフォーマンスを行っている。

十数年後、現在のコンピュータ音楽の技術的状況をひとつの歴史として振り返ったとすれば、ここ数年の「パーソナル・コンピュータ上の、ソフトウェア・シンセイサイザーあるいはリアルタイム・シンセシス環境の急速な発展と充実は革命的であった」と記述されていることだろう。それまでのテクノ・ミュージックで主に用いられていた「MIDI」は、人間の指のレベルのイベントを取り扱う。MIDIは規格としては最大で31.25kbpsの情報伝達能力をもつが、実際にはせいぜい1秒間に数十音分程度の処理を行えればよいことから、1980年代のパーソナル・コンピュータ程度の性能でも、充分リアルタイムで使用可能なモデルであった。

それに対して、CDクオリティのサウンド・シンセシスをリアルタイムに行うためには、最低でも1秒間に88200個の16ビット(2バイト)データを、複数のオシレータやフィルターで処理する必要がある。11μsに1データという、高速なデータ・プロセッシングを行うためには、MIDIデータの操作に比較して、ざっと数千倍から数万倍の処理能力が必要とされる。加えて、同等のクオリティのサウンド・データ(オーディオ・ファイル)を保存しておくためには、MIDIデータに比較して、やはりおおよそ数千倍以上の記憶容量が必要になる。

リアルタイムのサウンド・シンセシス革命を引き起こした主な要因が、パーソナル・コンピュータの処理速度の進歩と小型化、メモリーやハードディスクの大容量化と価格の低下にあることは言うまでもない。技術革新は、技術の進歩があるスレッショルド(閾値)を越えたときに突然生じる。では、その技術革新が引き起こしたものは何だったのか? それは単に、汎用コンピュータによるシンセサイザーやサンプラーのシミュレーション、つまりシンセサイザーやサンプラーといった専用マシンのソフトウェア化だけでなかった。

オーディオ・ファイルという音波レベルの処理は、耳の知覚や認知心理学レベルのできごとと直接かかわってくる。MIDIと専用の外部音源、という組み合わせによる既存の楽器のシミュレーション、あるいはサンプリングによる現実世界のメタファーや既成事実のコピーやカットアップではなく、空気の圧力波形そのものを産出し、処理するという、ダイレクトな操作の明晰さや柔軟さが、リアルタイム・シンセシスの大きな魅力のひとつである。

サウンド・シンセシス革命の結果、リアルタイム・シンセシスのためのプログラミング環境が民主化されたことも重要だ。1980年代の半ばから、世界に数台程度しかない特別の専用マシンや拡張ボードを使うことで、複雑なサウンド・シンセシスや大規模なDSP(デジタル信号処理)を行うことができる大学や研究所(スタンフォードのCCRMA[14]やパリのIRCAM[15]など)や、商業的なスタジオがいくつか存在していた。しかしそれらは、ごく限られた、特権的な人々のためのものでしかなかった。

先ほどの汎用パーソナル・コンピュータの性能向上に連動して開発された、マッキントッシュ上で動作するMAX/MSP[16]やSuperCollider[17]の販売開始(ともに1997年)、ネトチカ・ネズバノヴ[18]によるnato.0+55+3d[19]をはじめとした様々なDSPソフトウェアの開発、そしてDSPボードの低価格化は、それまでの特権的でクローズドなリアルタイム・シンセシスの世界を、一気にパーソナルでオープンなものに変えた。リアルタイム・シンセシスのためのプログラミング環境は、今では多くの人々にとって、決して高嶺の花ではない。

どんな世界においても、施設や機材的な独占はある種の権威と結び付きがちである。リアルタイム・シンセシスの普及によるDSPの民主化に伴って、ストリート・カルチャーというオルタナティブな文化が、この世界をぐいぐいと牽引し始めた。パーソナル・コンピュータは、特殊で高価な専用マシンのような閉ざされたものではなく、柔軟でリベラルな思想の具現である。リアルタイム・シンセシス環境の民主化は、そうした多くの人々にとっての身近な実感とも馴染みやすいものであった[20]。

[14]スタンフォード音楽音響コンピュータ研究センター・CCRMA(Center for Computer Research in Music and Acoustics)は、作曲家と研究者が、芸術的メディアとして、また研究ツールとして、コンピュータベースのテクノロジーを使って共同作業を行う学際的な施設である。教育研究以外にも、地域のコンピュータ音楽センターとの交流コンサートを含め、コンピュータ音楽のコンサートを毎年数回開催。また、CCRMAで進行中の研究の公開デモンストレーションを定期的に行っている。

CCRMA公式サイト:https://ccrma.stanford.edu/

[15]IRCAM(Institut de Recherche et Coordination Acoustique/Musique)は、ピエール・ブーレーズによって組織され、1977年にポンピドゥー・センター内に設けられた、音響音楽表現と科学研究の双方が協働する世界最大級の公的研究センターである。80年代後半にはミラー・パケットを中心に、音楽ソフトウェア「MAX」シリーズの開発と実践の場となった。現在の所長は、フランク・マドレーナー。芸術的感性と科学技術の革新が交錯するこの研究センターには、160人を超える協力者が集まる。2020年、IRCAMは研究所のオーディオ・イノベーションを商業化するためのスピンオフ会社、Ircam Amplifyを設立した。

ICRAM公式サイト:https://www.ircam.fr/

Ircam Amplify公式サイト:https://ircamamplify.com/

[16]MAXは、アーティストでもあるデイヴィッド・ジカレリが立ち上げたサンフランシスコのソフトウェア会社・Cycling ’74によって開発・保守が行われている、音楽と映像、マルチメディアのためのビジュアルプログラミング言語である。

MAXの名は、世界初の音楽プログラミング言語・MUSICを開発したマックス・マシューズに由来し、オブジェクトをパッチコードで繋いでいくというそのプログラミング・スタイルは、初期のアナログ・シンセサイザーのパネルをメタファーとする(それゆえ、MAXのプログラムは「パッチ」と呼ばれる)。

なお、ミラー・パケットは1996年、Pure Data(Pd)というMAXのスタイルを踏襲しつつ完全に再設計されたオープンソースのプログラミング環境を独自にリリースした。

1990年の発売当初はMAXで扱えるのはMIDIデータのみだったが、1997年にはPdのコードをベースにしたMSPというリアルタイムのオーディオ処理能力が加わり、「MAX/MSP」という名称で販売されるようになる。さらに2003年にはJitterという画像処理のための追加モジュールが販売を開始した。ヴァージョン5からはすべてのMAXにJitterが含まれるようになり、MAXとMSPとJitterがひとつのパッケージとして販売されるようになる。以降、商品としての名称は再び「MAX」となった。その後2017年にCycling ’74社はAbleton社が買収、提携関係となったが、現在もMAXはCycling ’74社から販売される形になっている。

MAX公式サイト:https://cycling74.com/products/max

ミラー・パケットによるMAXの解説「Max at Seventeen」:http://msp.ucsd.edu/Publications/dartmouth-reprint.dir/

「Max at Seventeen」日本語訳:https://www.shintaroimai.com/MaxAtSeventeen.html

Pure Data公式サイト:https://puredata.info/

[17]SuperColliderは、ジェームス・マッカートニーが1996年に発表した、リアルタイムオーディオ合成とアルゴリズミック作曲のための、フリーでオープンソースのプログラミング環境。Smalltalkのオブジェクト指向構造と、関数型プログラミング言語の機能を、Cファミリーの構文で組み合わせた、テキストベースのプログラミング言語である。2002年に発表されたヴァージョン3からは、OSC(Open Sound Control)で通信するサーバーのscsynthとクライアントのsclangという2つのコンポーネントに分割された。汎用の動的プログラミング言語として、ライブコーディング、つまり演奏者がその場でコードを修正したり実行しながら行う演奏にもよく用いられる。

SuperCollider公式サイト:https://supercollider.github.io/

[18]ネトチカ・ネズバノヴ(Netochka Nezvanova)は1848年にドストエフスキーが執筆を開始した、「無名の凡人」を意味する未完の小説のタイトル=主人公の名前に由来する。「クロスポストは美学である」と称する彼女の大量のスパムまがいのメールは、暗号かつコード詩的な「English+」で書かれ、アスキー記号と多言語の分裂した断片によって過剰に修飾されていた。またそのメッセージの中には、論争的な資本主義や政治批判と、ユニークな哲学的声明が混ざり合っていた。ソフトウェアだけでなくこうした活動全般に対して、非営利団体のSF WoW(San Francisco Women on the Web)は、彼女を2001年の「ウェブで活躍する女性トップ25」に選出した。

2005年からは、名前を出生時のレベッカ・ウィルソンに戻してプログラマーとして活動。2018年には、音楽とネットワーク技術という2つの情熱を融合したネットワーク音楽パフォーマンスをテーマに、ヴィクトリア大学ウェリントンのNew Zealand School of Musicで修士の学位を取得。2006年にはElisabeth Schimanaが監督した20分のドキュメンタリー映画『Rebekah Wilson aka Netochka Nezvanova』が、オーストリアのIMA(Institut für Medienarchäologie)により制作・公開された。

[19]nato.0+55+3dは、Jitter以前の1999年にMAX/MSP用にリリースされた、リアルタイムビデオとグラフィックスのための拡張パッケージ。MAXから、QuickTimeがサポートするすべてのメディアタイプ(画像、動画、3Dモデル、QuickTime VRなど)へのアクセスと操作を可能とした。

[20]ここまで紹介してきたコンピュータミュージックの革新は、現在ではすでに「クラシック」なものとして、先端的なアーティストに参照され始めている。デンマークのサウンドアーティストであるMarc Hasselbalchは、2020年11月、ディスカッション・フォーラムの「llllllll(ラインズ)」に、以下のような投稿を行った。(出典:https://llllllll.co/t/classic-laptop-computer-music-patches-and-software/)

ここしばらく、僕は1990年代から2000年代初頭にかけての「クラシック」なラップトップコンピューターミュージックの時代と、そこで使われたソフトウェアやテクニックにとても興味を持っている。(中略)誰か面白いMax/PD/Supercollider/その他のパッチを持っていたら、ぜひシェアしてほしい。(著者訳)

この投稿には400を超えるリプライがあり、今なお脈々とつづく様々なソフトウェアやハードウェア、インターフェースの実験の、当時の熱気を彷彿とさせる事例が記録された。

MIDIモデルからの解放

パーソナル・コンピュータ上で、DSPプログラムが実用的なレベルで動くようになることで実現した、リアルタイム・シンセシス環境の民主化は、それまでコンピュータ音楽の代名詞のように思われていた、ピアノ鍵盤型のキーボードあるいは五線譜モデルにもとづく、MIDIモデルからの解放を促した[21]。

音の高さ(音高)を縦軸、時間を横軸とする直交座標系をベースにした、伝統的な五線譜による音楽の記述は、基本的に離散的、構成的である。音の高さについては、ほぼ振動数の対数が階段状に分けられ、その組み合わせが音階(スケール)を構成する。音の長さ(音価)は、1小節という楽譜の縦線で区切られた、演奏速度によって決められる時間的部分を基準に、その何倍、あるいは何分の1といった比率で、これも2のべき関係、あるいはその等分をもとに離散的に記述される。音の大きさ(強度)も「ppp – pp – p – mp – mf – f – ff – fff」といった強弱記号や強弱標語で、記号がひとつ上がるごとにほぼ2倍の音圧になるように、段階的に指定される。音楽は、これらの定量的かつ離散的な要素をボトムアップに組み合わせていくことで、記述される。

一方、音色は主に、楽器の種類によって記述される。音楽作品を構成する素材としての音(楽音)には、規則正しく一定の周期をもって継起する、音の高さや音の長さが明確な音色を持った楽器が好まれる。ピアノやギター、バイオリンやトランペットなど、西洋の伝統的なオーケストラを構成する楽器は、みなそうした特徴を持っている。

あわせて、地球上の動植物の種類が、種ごとに分類されているように、音色も楽器の種類ごとに記述されている。もちろん、そのことが音楽にとって、必ずしも負の制約になっているわけではないが、普段、バイオリンとティンパニやホルンとピアノの間の音色、あるいは一定の音程や明確な音価をもたない楽器などについて考えることは、あまりない。同様に、尺八のムラ息や三味線のサワリのように、ノイズを伴う音や、リズムの微妙なゆれや伸縮の記述も難しい。

MIDIにおいてもそれはまったく同様である。記述の対象になるのは、まず、音高、音価(正確には音の始まりと終わり)や音量、といった定量的かつ独立なパラメータであり、音色という定性的で有機的な要素は、五線譜の場合と同じように、外部音源の音色の選択やコントロールチェンジといった、副次的な要素でしか記述されない。MIDIモデルは人間の指のレベルのイベントを取り扱ってはいるが、キーボードの鍵盤を、整然と並んだスイッチ列とみなしているため、人間の指や手、腕や身体がもっている豊かさやしなやかさの伝達も困難である。

連続的に変化する数値をMIDIで送るのには限界がある。

MIDIはキーボードをモデルにしていて、

音のパラメーターを離散的にとらえている。

連続的な変化はチャンネルごとに1つしかできない。

ある和音を構成する音が

独立に音量を変えていくようなことは不可能。[22]

MIDIは確かに、コンピュータのシーケンス・ソフトや、スイッチとしてのキーボードでコントロールされるシンセサイザーを接続するためには、適度なレベルの抽象モデルであったかもしれない。しかし、その簡便さの代償として、失われたものも大きかった。

[21]認知科学者のD.A.ノーマンは、情報アプライアンス(家電)の必要性をマーケティングの観点から説いた著書、“The invisible computer”(邦訳『パソコンを隠せ、アナログ発想でいこう!――複雑さに別れを告げ、〈情報アプライアンス〉へ』、新曜社、2000年)の中で、最も有効で広く受け入れられている情報アプライアンスの原型として、音楽用MIDI機器(音楽アプライアンス)を真っ先にあげている。しかし音楽制作の現場においてノーマンが考える未来は、同書の刊行時すでに過去のものとなってしまっていた。

[22]高橋悠治『音楽の反方法論序説』(青空文庫)

https://www.aozora.gr.jp/cards/000059/card374.html

クリックとノイズの狭間に

音の高さや音の長さをもとにしたキーボード・モデルの構造には、メロディーやリズムのように水平的なものと、ハーモニーやポリリズムのように垂直的なものとがある。いずれもパルスの集積、あるいは等分に刻まれた拍子としての「時間」が、構造の基本パラメータになっている[23]。

それに対して、現在のサウンド・シンセシス/DSP環境では、そうした孤立した音群ではなく、あらゆるレンジにわたるスペクトル、つまり振動(サイン波)の連続的な集合体を基本とする「周波数」モデルを使って音を操作することができる。そこではスペクトルの強度分布の時間変化で表される「音色」という、非パラメトリックな要素のデザインが、従来以上にクローズアップされる。伝統的な五線譜上では、音色は、楽器とその運指、運弓、運舌などの指定、デュナーミク(強弱法)やアゴーギグ(速度法)、フレージングやペダリング、そして「あらあらしい」「輝かしい」「鋭い」「温和な」といった情緒的な表現を用いて、音高や音価に比べて補助的かつ、あいまいにしか記述できなかった。

フーリエ変換により生成される周波数空間上で、それ以上分解不可能な音のアトムとしての定常サイン波(一定の純音)は、ひとつの点で表される。一方、時間軸上でのひとつの点、すなわちクリック音は、周波数空間上では、すべての周波数をほんの少しずつ含んだ連続スペクトルとして表現される。サイン波の表現には、サイン関数を近似したウェーブテーブルが必要であるのに対して、クリック音はサウンドファイル上のひとつの数だけで表現でき、量子化ビット数にも依存しない。数字列で表現されるデジタル・サウンド(サウンドファイル)のアトムは、サイン波ではなくクリック音である[24]。

クリック音という点の離散的な集合体、あるいはその運動体としての線、拡がりとしての面や立体が、一般の複合音を作り上げる。すべての周波数の音をわずかずつ含む、決定論的な「クリック」と統計的な「ホワイト・ノイズ(白色雑音)」が、音色やハーモニーの領域を設定し、その大規模な構造がリズムやメロディーを派生させる。それらはまた、周波数領域の中で再帰的に定義される。

[23]以下の文献を参照。高橋悠治「リズムと〈間〉」、『テクノカルチャー・マトリクス』(NTT出版、1994年)所収

[24]デジタル・サウンドにおけるクリックは、数学的な極限としてのクリックではなく、有限の長さ(1サンプリング時間)を持った、最小のパルス幅の矩形波である。

耳とスペクトル

音楽におけるフーリエ変換の重要性は、「不連続関数をも含む、あらゆる周期関数はすべて、サイン関数やコサイン関数の和として表現できる」、言いかえれば「楽器などの複雑な音色が、基本周波数の整数倍の周波数を基本にした、サイン波という単純な音のあつまりとして表現できる」……ということだけではない。人間の耳がもつ生物学的な構造の中には、この数学的な操作モデルに対応した「蝸牛」というバイオ・フーリエ変換器が存在している。

もちろん人間の聴覚は、音を直接、複数の正弦波の和として知覚しているわけではないし、音の周波数=音程、振幅=音量、といったような単純なモデルで働いているわけではない。それでもスペクトル・モデルを用いた音楽/音響制作は、耳という聴覚器官やその特性とダイレクトにかかわってくる。

人間の聴覚システムには、MPEGオーディオのようなサウンドファイルの圧縮に用いられるマスキング効果や、複数の音のなかから、ある特定の音だけを取り出す「ブラインド・ソース・セパレーション」、いわゆるカクテルパーティー効果などの、様々に絡み合った音響心理学的特性がある。ブラインド・ソース・セパレーションには、単なるフーリエ変換によるコンポーネント分離以上の、3次の非線形項が関連しているとされている[25]。

[25]西脇貴之・中山謙二・平野晃宏「グループ分離と線形化による非線形BSS における収束性解析」19th SIP Symposium(2004)

http://leo.ec.t.kanazawa-u.ac.jp/~nakayama/pub/file/dsp_symp/04_nishiwaki.pdf

ポスト・テクノ(ロジー)・ミュージック

スペクトル・モデルをベースにした音楽の再構成は、パーソナル・コンピュータによるリアルタイム・シンセシス環境の民主化を待つまでもなく、1950年代初頭のシュトックハウゼンに端を発する電子音楽の誕生と発展の中で、様々な試行錯誤が行われていた。

シュトックハウゼンは、日常生活の中の具体音を素材に抽象的な芸術表現を目指した「具体音楽(ミュージック・コンクレート)」というテープ音楽に対峙するものとして、フーリエ変換の理論をベースとする、還元主義的な「電子音楽(エレクトロニック・ミュージック)」のコンセプトを提起した。そこでは、音高や音価、強度といった、音のパラメータを数字列の操作で記述するという、ミュージック・セリエルの手法に残された最後のパラメータとしての「音色」を、演奏の際のタッチや奏法といった定性的なパラメータではなく、数値を使って完全にコントロールすることを目標としていた。

電子音楽における様々な試行錯誤が一段落した1971年、シュトックハウゼンは、電子音とピアノと打楽器のために書いた彼の集大成かつ最高傑作である「コンタクテ」を例として挙げながら、以下の4項目に電子音楽の特徴をまとめている。

- 統一された時間構造

- サウンドの分割

- 幾層にも重なった空間のコンポジション

- 楽音とノイズの同等性[26]

これらのいずれもが、先ほど述べた周波数領域における概念や操作と深くかかわっている。「統一された時間構造」とは、音高や音色、リズム、形式といった音楽を構成する様々な要素を、振動(バイブレーション)のいくつかの相として、スペクトル領域の中にマッピングすることである。「サウンドの分割」は、スペクトル領域におけるフィルタリング操作、「空間のコンポジション」はマスキング効果や、ディレイや残響処理に関する問題、「楽音とノイズの同等性」は、スペクトル上で決定的、周期的な楽音と偶然的、非周期的なノイズの連続体を考えることと、深く関連している。

パーソナル・コンピュータによるMIDIフリーなリアルタイム・シンセシス環境の民主化は、MIDIによって復活したキーボード・モデルという前電子音楽的、テクノ・ミュージック的なインターフェースを再解体すると同時に、シュトックハウゼンらによって開拓された電子音楽への回帰と再解釈を促した。メゴのピタ、パン・ソニックや池田亮司らに端を発し、秋田昌美[27]、そして佐々木敦[28]が「テクノイズ」と名付けた世界同時多発的な音楽/音響的ムーヴメントであるポスト・テクノ(ロジー)・ミュージックも、シュトックハウゼンが挙げた電子音楽の4つの特徴の今日的な実践の一形態と捉えることができる。

しかし、1970~80年代のミニマルやノイズ、フリー・インプロヴィゼーション、ワールド・ミュージック、そしてサンプリングやエレクトロ−アコースティックの音を体験した耳や、格段の進歩と広範な普及を遂げたテクノロジーのことを考えれば、それを単なる電子音楽の再来、あるいは追体験とみなすことはできない。1950~70年代の電子音楽や、1980年代のテクノ・ミュージックと、現在のポスト・テクノ(ロジー)・ミュージックを分けているものは何だろうか。ここではそれを、「インターフェース」と「デジタル」という2つの視点から考えてみることにしたい。

[26]シュトックハウゼン、前掲書

[27]秋田昌美『ノイズ・ウォー――ノイズ・ミュージックとその展開』(青弓社、1992年)

[28]佐々木、前掲書

インターフェース・デザイン

ミュージック・マガジン誌1999年2月号のインタビューで、マーカス・ポップはこう語っている。

音楽はもはや“作り手の主観的な視点や楽曲を作る才能や手先の器用さに基づいて何かを作り出す行為”などではなく、“ソフトウェアの公開データ検査のツール”になってしまっている。(中略)結局、僕がやっているのは、音楽という領域だけで判断されるべきではない。僕も作り手というよりは、特定のメディアが到達した現状を代弁している者にすぎない。すべてはユーザー・インターフェースなんだ。でもそれが悲劇だとは、僕は思わない。[29]

マーカスの言う「ユーザー・インターフェース」は、単にコンピュータ画面のGUI(グラフィカル・ユーザー・インターフェース)のことを指しているわけではない。インターフェースには、大きく分けて、身体的なものと社会的なものとがあるが[30]、ここにはその両方の意味が含まれている。身体的なインターフェースとは、個人としての身体が、コンピュータや楽器を含む、周囲の環境とかかわる際に生まれる、あるいは用意される状況のことである。

個人とコンピュータが接する状況をデザインする際に、まず考えなければならないのは、人間の生物的/物理的身体の特徴である。シンセサイザーのインターフェース・デザインにおいても、最近は液晶ディスプレイを用いた階層型メニューによるものよりも、モーグやブックラといった初期のアナログ・シンセサイザーや、航空機やレーシング・カーの操作システムのように、つまみやスイッチがたくさんついたコックピット型のものが好まれている。小杉武久やデーヴィッド・チュードアのように、所狭しとサウンド・ガジェットを並べて演奏する、ライヴ・エレクトロニクスのインターフェースもコックピット型だ[31]。

コックピット型のインターフェースが持つ、大きさや長さといった様々なディメンション(寸法)は、指の本数や長さ、手の構造や大きさ、視覚や触角、そして手や指の運動の特性といった、人間の身体が持っている物理的制約によって決められる。そこでは、練習を重ねることで身につけたスキルや、人間の身体の側がインターフェースに適合していくダイナミズムが重要な役割を果たしている。人間の身体やその運動学的な特徴に適合させた、エルゴノミックなインターフェースのデザインも場合によっては必要だが、同時に人間が欲望に導かれて環境に適合していく能力や柔軟性の高さ、そこから生まれる可能性と喜びも、決して無視するわけにはいかない。

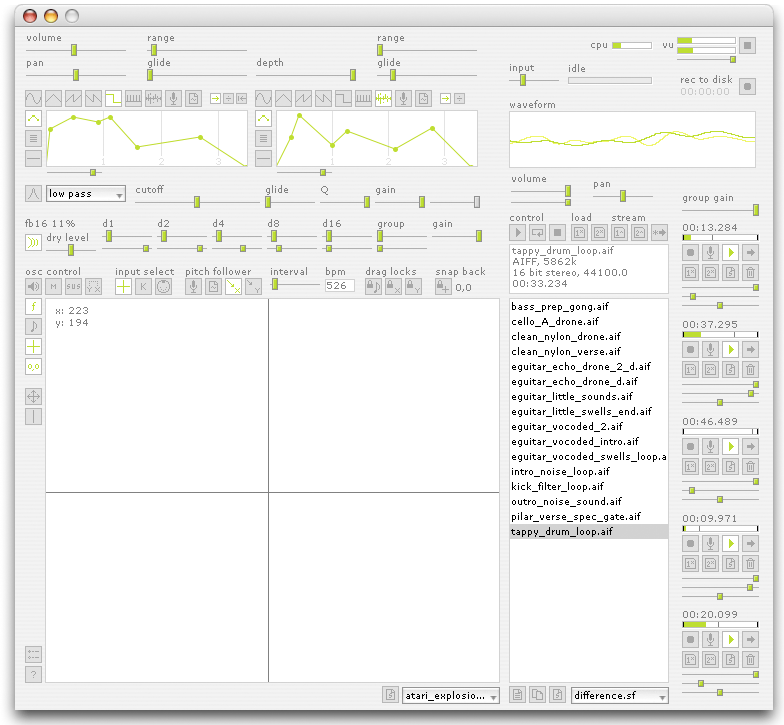

一方、コンピュータ側から、プログラムで記述された手順にしたがって、音楽を半ば自動的に生成(作曲)していく方法を、アルゴリズミック・コンポジションと呼ぶ。1980年代の終わりに、カール・ストーンが小型のパーソナル・コンピュータ(AppleMacintosh SE)とMIDI音源を駆使して行ったアルゴリズミック・コンポジションのリアルタイム化は、あたかもノン・イディオマティックなフリー・インプロヴァイザーのように、作曲者と演奏者の垣根を取り払う、コンピュータを用いたインスタント・コンポジションの可能性を示した。

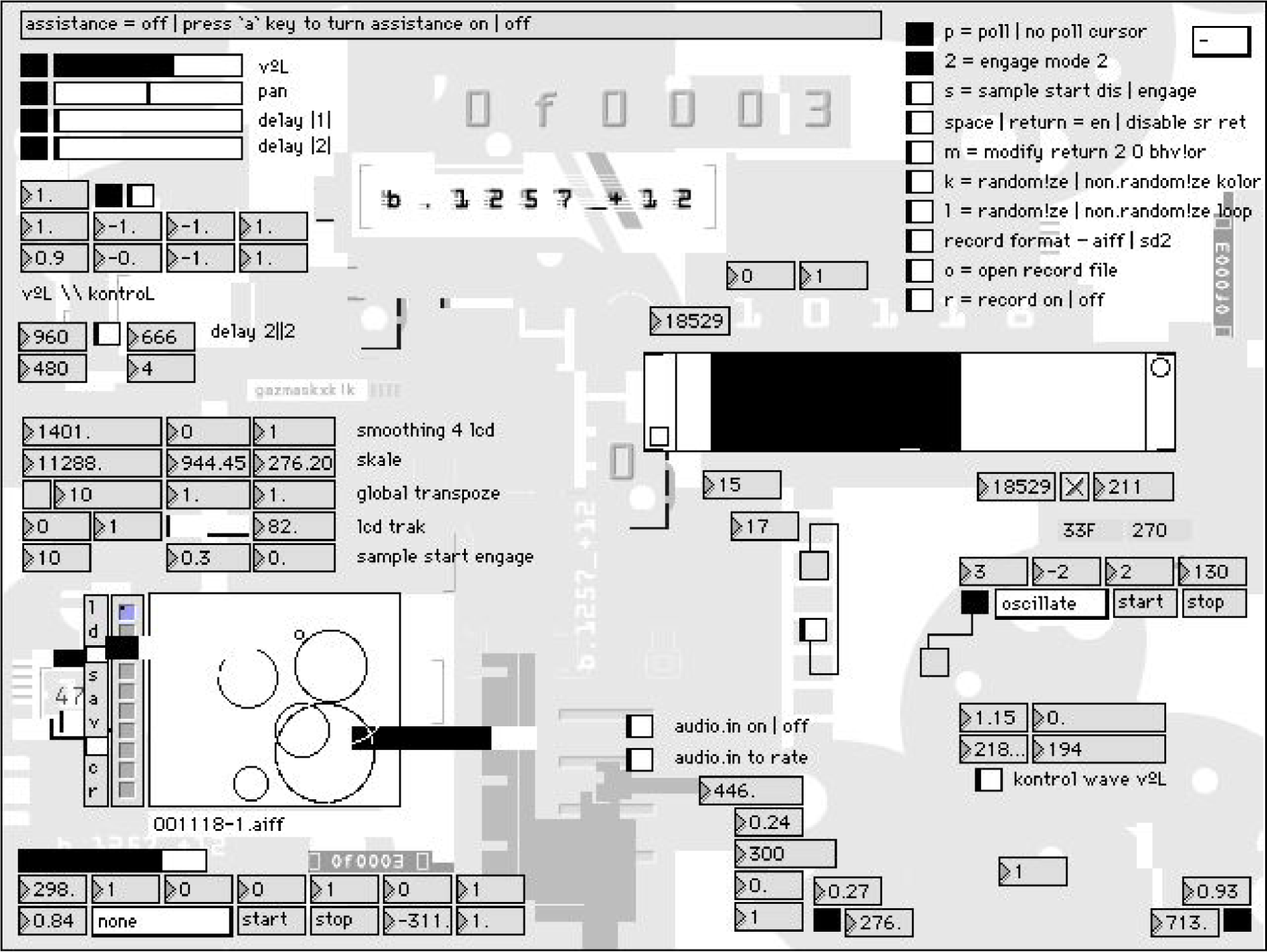

ユーザーが自由にプログラミングすることができるリアルタイム・シンセシス環境の代表例であるMAX/MSPは、「オブジェクト」と呼ばれる画面上の矩形領域を、「パッチ・コード」という線でつないでいく、パッチベースのGUIでアルゴリズムを記述する[32]。通常のテキストベースのプログラミングに比べて、オブジェクトとパッチ・コードは有限のディメンション(大きさ)を持っていて、その配置としてのプログラミングには、人間とコンピュータ双方の制約が強く反映される。

言い換えれば、MAX/MSPのようなグラフィカルなビジュアル・プログラミング言語は、アルゴリズムとインターフェースを分離せずに書くことができる(書かなければならない)。つまり、作曲という行為における、アルゴリズムやモデルの選択という、ディメンションを持たないコンセプチュアルなレベルと、アルゴリズムの可視化や観測と操作、あるいは介入可能部分の選択というディメンションを持ったビジブルなレベルのデザインが、渾然一体として見分けがつき難くなる。

アルゴリズミック・コンポジションとインターフェース・デザインの融合が意味しているのは、音楽作品の創作行為を表す作曲(コンポジション)、そして記譜(記述)という概念の融解である。たとえ同じデータ、同じアルゴリズムを記述したとしても、それらの見え方や操作の仕方を規定するインターフェースのデザインが変化すれば、異なる音楽作品が生まれる。

インタラクティブな部分を持たない非リアルタイムなアルゴリズミック・コンポジションでは、データとアルゴリズムの組が曲(ピース)に相当していた。インタラクティブなアルゴリズミック・コンポジションの場合、データとアルゴリズムに加えて、それらに対する観測と介入を提供するインターフェースの組が曲に相当する。インターフェースの自由度が大きくなると、作曲という概念は、音楽作品のモデル構造の記述という枠組みを超えて、コンピュータを用いた楽器のデザインとその演奏法という一連の行為へと拡散していく。広い意味でのインターフェース・デザインが、そこから立ち現れる音楽の姿を主体的にかたちづくっていくのだ。

つまり、今日のコンピュータ音楽においては、楽器=インターフェース、演奏=その使用(ユーズ)なのである。するとそこには、新たに定義されたモデルとしての楽器に対する取扱い説明書や使用例が、作曲の概念として登場してくる。

[29]松山晋也「マーカス・ポップ・インタビュー」、『ミュージック・マガジン』1999年2月号(ミュージック・マガジン)所収

[30]久保田晃弘『遙かなる他者のためのデザイン』(ビー・エヌ・エヌ、2017年)

[31]東京大学の中井悠が2021年に上梓した、デーヴィッド・チュードアの音楽についての研究書『Reminded by the Instruments』(オックスフォード大学出版局)に付属のウェブサイトに、チュードアが残した様々な電子ガジェットやその回路図、インタビューの書き起こしなどが掲載されている。

http://remindedbytheinstruments.info/book.html

また、チュードアの1998年作品『Rainforest』のジャケットには、コックピットの中で演奏するチュードア自身の姿が写っている。

https://www.discogs.com/ja/master/846439-David-Tudor-Rainforest

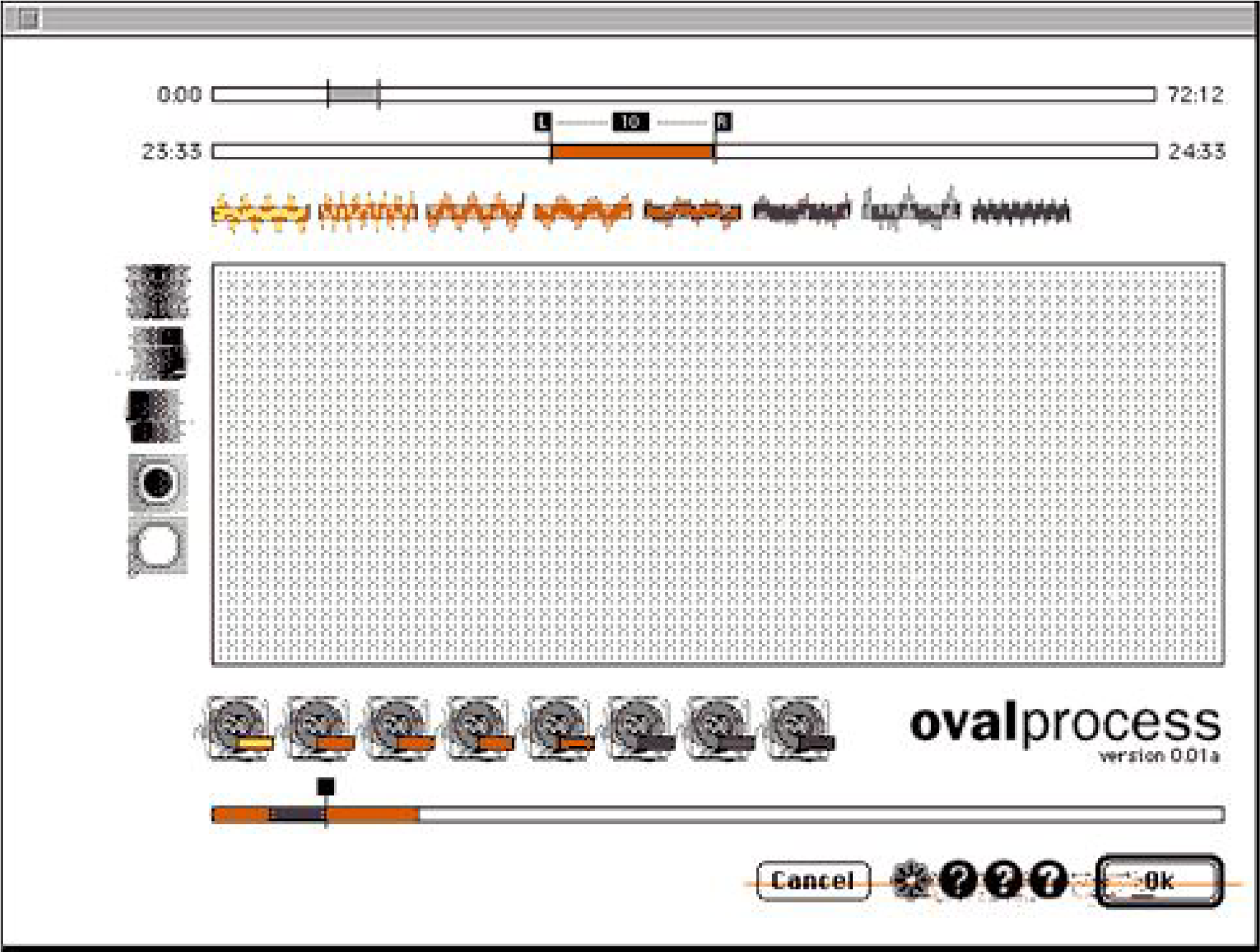

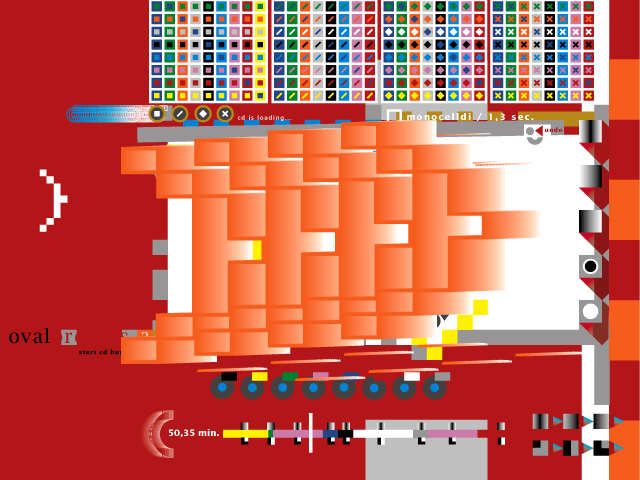

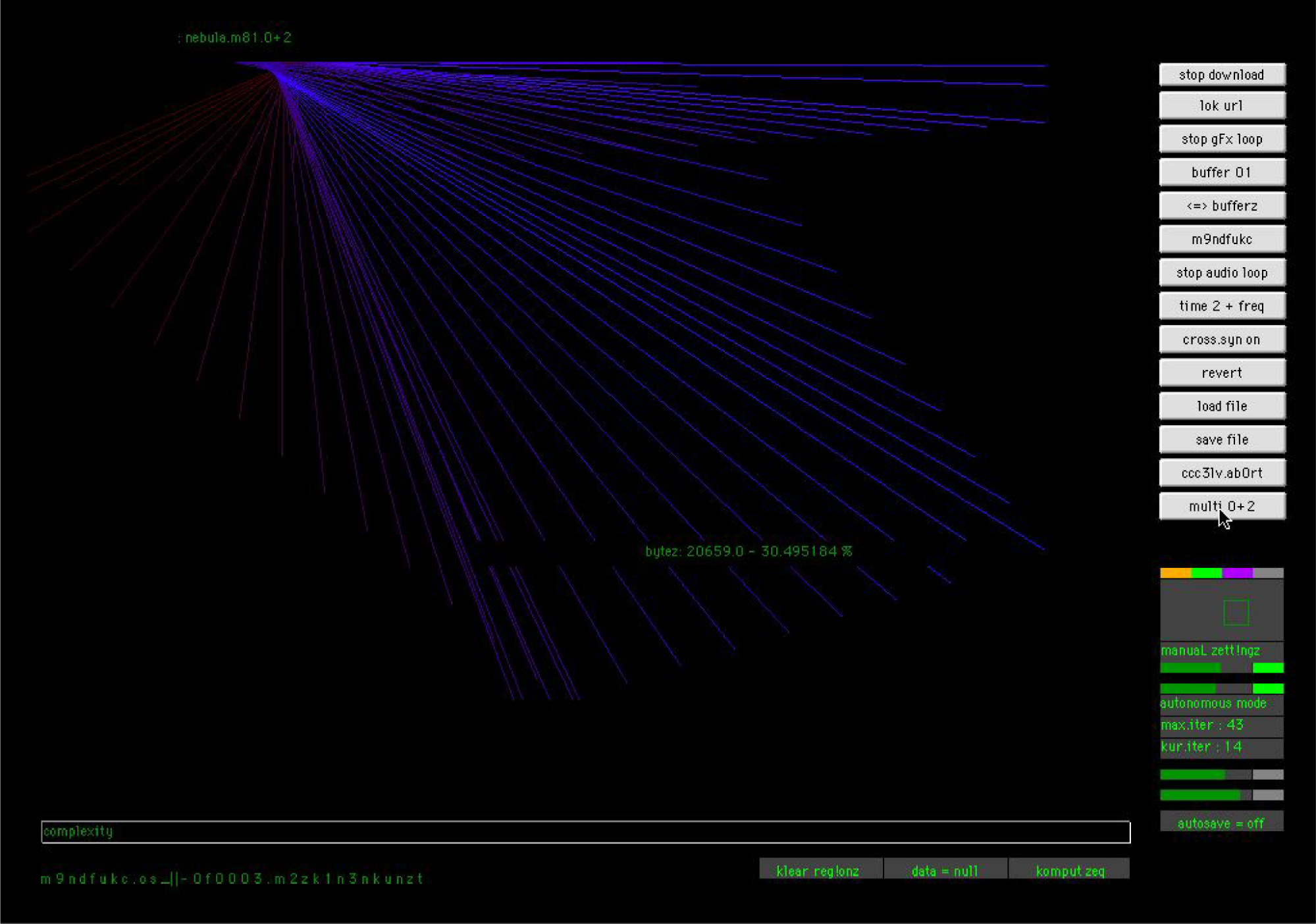

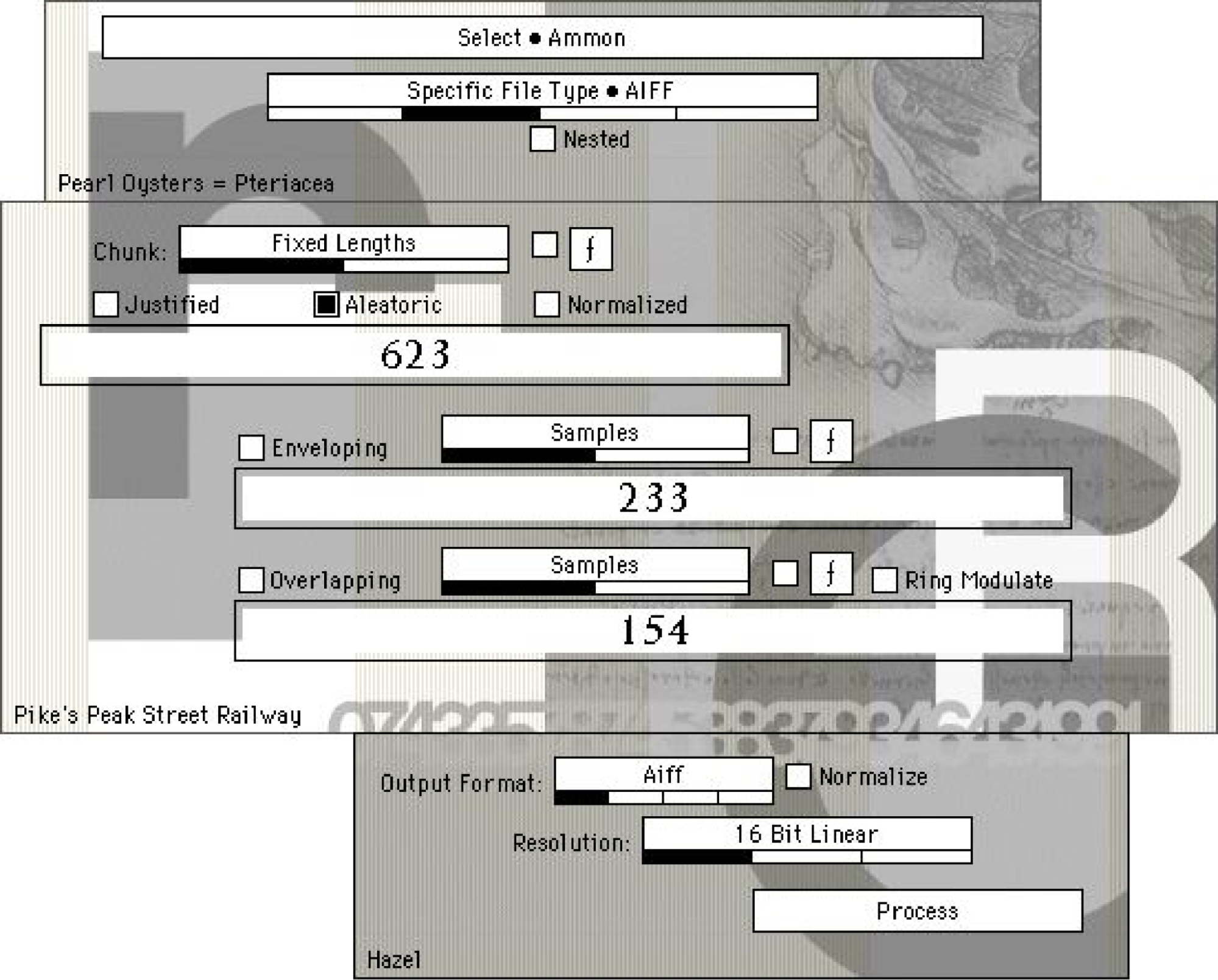

[32]MAX/MSP/nato.0+55+3dのプログラミング例(左半分にある「242」で始まるオブジェクトと赤い画像が、nato.0+55+3dによるもの)

[33]ここで挙げたプロジェクトを含む、オヴァル初期の活動に関する情報(テキストやインタビュー、制作物のリストなど)は以下より閲覧できる。

https://web.archive.org/web/20070702002650/http://www.meso.net/oschatz/oval/index.html

なお、オヴァルはもともとマーカス・ポップ、セバスチアン・オーシャッツ、フランク・メッツガーの3名によるプロジェクトだったが、オーシャッツとメッツガーは1995年に脱退。以後はマーカス・ポップのソロプロジェクトとなっている。

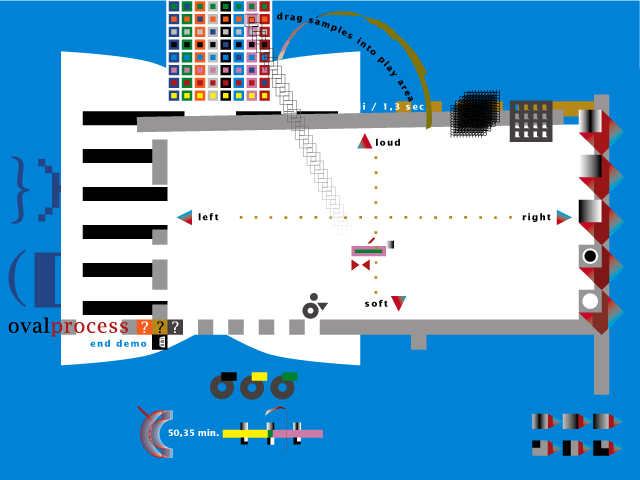

オヴァルプロセス初期ヴァージョンのインターフェース

オヴァルプロセス2000年バージョンのインターフェース

[34]原雅明「カルチュラル・エッジ・インタビュー:オヴァル(マーカス・ポップ)」

https://web.archive.org/web/20020222192812/http://www.hotwired.co.jp/culture/interview/981110/

[35]カール・ストーンはこうした状況を、その活動の初期から批判的に肯定・活用していた。彼の初期の有名な作品「ウォール・ミー・ドゥ」(1987)は、「M」というソフトウェアのデモ・プログラムを試していたときに、たまたまその中に入っていた基本パターンを使って作られた。環境音とはまた違った意味で、ソフトウェアによるファウンド・サウンド(見出された音)の一例といえる。

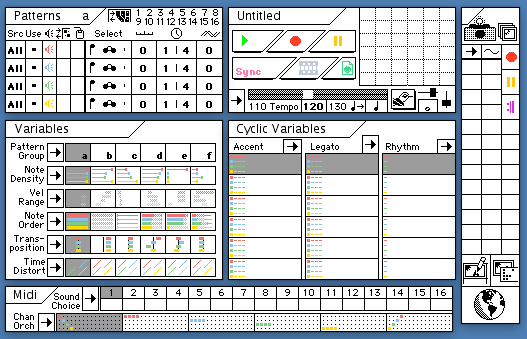

「M」のインターフェース

[36]このマーカス・ポップのアプローチからは、ジョン・ケージの「偶然」の技法も想起されるだろうが、両者は本質的に異なっている。ケージは偶然を使用することで、意図されていない音の集まりとしての沈黙(サイレンス)と音とを取り替えた。つまり偶然という手段をつかって、「表面的」な音楽の注文に応えられるかどうかを試したのだ。その一方でケージは、ある特定のアーティストという個人の神話から決して逃れようとはせず、むしろそれを最大限に利用し続けた。

「オリジナル」の消滅

インターフェースの問題は、単にコンピュータの画面上でのできごとに限られるわけではない。マーカスは「オヴァルプロセス」を、楽器としてのプレイバック・エンジンや、サウンド・インスタレーションのためのソフトウェアとしてだけではなく、それを拡張されたオーディオCD(CDエクストラ)やゲームソフトとしてマーケット上で流通させたり、一般の人が触れられるターミナルとして街頭に設置することで、「誰でもオヴァルの音楽を作ることができ、誰でも今すぐに始めることができる」という状況を、社会的、公共的にも作り出そうとしている。

このことは、素材に依拠せず、伝統的な意味での主体、あるいは作家性といったパーソナルなクリエイティビティを、パブリック・ドメインにおくことで積極的に消去した、新たなアートのありかたと考えることもできるし、ゴール(作品)指向からプロセス(ワークフロー)指向へ、というデザインの移り変わりの、ひとつの現れとみることもできる。

このようなマーカス・ポップのアプローチと深く関係しているのが、「オープンソース」という脱著作権の考え方である[37]。著作権は、作品の表現の部分を保護するためのシステムである。一方、表現ではなくアイデアそのものを保護するためのシステムとして、特許がある。数学的・科学的なソフトウェアの場合、アルゴリズムというアイデアが特許権、プログラムという表現が著作権とかかわるものとみなされる。

それに対して音楽ソフトウェアのような、ある程度のインタラクティビティを持つソフトウェアの場合、著作者はコンピュータのオペレータ(使用者)であり、コンピュータや、プログラムやデータの作成者ではない、とみなされる。オリジナルなアイデアとはいったい何なのか? 著作者とはいったい誰なのか? 数学ソフトと音楽ソフトの間にはどんな違いがあるのか?――表現を生成するソフトウェアの操作をユーザーにゆだねたり、オーディオCDを「オヴァルプロセス」のサンプル・ファイルと位置付けるマーカスの実践は、オリジナリティーや表現に対する旧来の考え方の間隙を鋭く突く。

デジタル表現の第1の特徴は、オリジナルとコピーの差異を無化する「劣化なきコピー」と、そこから生じるオリジナルの消滅である。この第1の特徴と、ネットワークによるプログラムやデータの自由な流通により育まれたオープンソースの思想は、従来のクリエイター中心主義の著作権システムではなく、利用者による再利用や改変の自由を保証した「ユーザー中心」の情報共有社会の構築を目指す。

コンピュータ・ネットワークの浸透とリアルタイム・シンセシス環境の民主化による、ソフトウェアやサウンド・ファイルの自由な流通と改変、リーズナブルな価格での販売、といった社会的インターフェースの変化は、作曲者と演奏者の垣根だけでなく、さらに音楽の聴取者としてのユーザーとの垣根を取り払う。サンプリングやリミックス、そしてプログラムとそのソースコードやパラメータ・ファイルの公開を通じて、今やほとんどの音楽制作は、実体的なレベルで相互に深く関連している。今日の音楽を規定しているソフトウェアには、単体としてのプログラムやサウンド・ファイルだけではなく、共同体におけるそれらの使用や共有の方法までといった、広い意味が含まれる。

[37]フリー・ソフトウェア/オープンソースの思想を、音楽制作のソースである、音楽ファイルの共有と交換/流通に対しても取り入れるべく1998年に始まったのが「GNUsic Project」である。以下、公式サイトであるGNUsic.netのステートメントを引用する。(出典:http://www.gnusic.net)

このGNUsic(GNU + Music).net Web Siteは、エレクトロニック・ミュージシャンのための、オープンなネットワーク制作スタジオです。このスタジオでは、音楽のソース・プログラムに相当する、様々な音楽素材やその制作ツール・手法を「フリー・ソフトウェア/オープン・ソース」および「コピーレフト」の考え方を参考に公開し、いつでもどこからでもアップロード/ダウンロードができるようになっています。

GNUsic.netの目的は、インターネットを使って音楽の制作プロセスを公開し、そこで作られた様々な素材やプロトタイプを広く再利用可能なものにすることです。これまでにも多くの創造的なミュージシャンたちが、インターネットを活用したコラボレーションで、音楽を作り上げてきました。しかし残念なことに、せっかくインターネットを活用したのにもかかわらず、そのプロセスの多くは公開されず、そこで制作された発展的プロトタイプを手に入れたり、自分の制作のために修正・再利用することは、ほとんど不可能でした。

GNUsic.netは、Linuxの開発スタイルのような、バザール方式の音楽制作コミュニティーを実験/実践するための第一歩です。この背景には、たとえミュージシャン一人一人の人生観や音楽観が異なったとしても、そこへ向かうプロセス(の少なくとも一部)は共有可能に違いない――そうした「(たとえ)総論反対(でも)、各論賛成」ならばコラボレートできる、という考え方があります。

オープンソースの思想に関しては、クリス・ディボナ、サム・オックマン、マーク・ストーン編著/倉骨彰訳『オープンソース・ソフトウェア――彼らはいかにしてビジネススタンダードになったのか』(オライリー・ジャパン、1999年)も参照。

デジタル・エラー

マーカス・ポップの音楽の作り方のもうひとつの特徴は、CDを早送り(CUE)したり巻き戻し(REVIEW)する際のスクラッチ音や、フェルトペンで落書きをしたCDを再生した際のスキップ音をサンプリングし、利用していることだ。オヴァルは、そうした非楽音のサンプルを、加工、編集し、ループさせ、そこから新しい音響ビートとも呼ぶべき、独自の緩やかな流れを作り出した。

レコードのスクラッチといえば、ヒップホップDJによるダンス・ミュージックや、大友良英やクリスチャン・マークレイらによるターンテーブル・ミュージックでよく用いられるが、オヴァルは同じことをCD(プレイヤー)というデジタル機器で行った。両者に共通しているのは、当初の設計段階では想定されていなかった使われ方や操作により偶然発見された逸脱的な挙動、つまり「エラー」[38]あるいは「グリッチ」[39]という概念である。

音楽の再生機器には、レコードやカセットテープ、CD、MDやDATといったデジタル/アナログ方式、ディスク/テープ方式といった様々な種類が存在するが、いずれの機器を用いたとしても、設計当初から想定された状況の範囲で使用している限り、ある特定の方式に対する狂信的、盲信的な信者や、微細な違いを顕在化させる極めて高価なシステムを用いた場合を除いて、機器による違いがそう大きく現れるわけではない。

デジタル機器とアナログ機器の相違が最も顕著に現れるのは、通常の動作状況を逸脱して「エラー」を起こした場合である。レコードの埃や傷による針飛びと、CDのトラッキングエラーの際に発生するサウンドは大きく異なっているし、レコードにおける33回転と45回転の取り違えや、手によるターンテーブルの回転、回転数に依存したノイズは、再生機器の特性に依存したエラーの典型例である。LPレコードの1回転を1小節とみなす133.3333…BPMのテンポは、多くのDJたちによって愛用されている。

強引な操作やメディアの劣化、保管ミスなどにより発生するアナログ・ディスク特有のエラーは、デジタル機器であるCDやMD、DATでは決して起こりえない。もちろんアナログ・エラーのデジタル・シミュレーションは可能だが、正常なシミュレーションはもはやエラーではない。

過大な入力によって生じる「歪」も、アナログ回路の歪(ディストーション)と、デジタル回路の歪(クリッピング)とでは、その質感は大きく異なる。かつて僕も使っていたAKAIのS3000XLサンプラーのマニュアルには「デジタル回路で生じる歪は、残念ながら昔のタイプ(アナログ)のシンセで生じたディストーションほど心地よいものではありません」と書かれていた。オヴァルやメゴのサウンドのような、クリック音やデジタルエラーの快感や美しさを知った耳にとって、このフレーズはすでに過去のものである。

正常な「楽音」に対する異常な「騒音(ノイズ)」という概念の背後には、音自体をひとつの独立したオブジェクトだと捉える考え方がある。それに対して「エラー」という概念は、音を独立したオブジェクトとしてではなく、音づくりの装置全体をシステムとして捉え、システム全体の挙動の変化に着目する[40]。エラーは、システムが当初デザインされた時点では想定されなかった状態で使用されることから生まれる。オヴァルやメゴらによるポスト・テクノ(ロジー)・ミュージックでは、このデジタル機器やソフトウェア固有の、システムエラーにより生まれる音の質感が、効果的かつ音楽的に用いられている。

内部構造やインプリメントの方法に依存したエラーを活用した音楽は「ノイズ系」ならぬ「エラー系」あるいは「グリッチ系」の音楽と呼べるだろう。システムの内部構造に着目したアプローチは、音楽の世界を長い間覆ってきた、表面的な機能主義や行動主義からの脱却をも示唆している。

シュトックハウゼンが電子音楽に着手して以来、1950~1970年代の電子音楽のための装置(電子楽器)は、アナログ機器がほとんどであった。デジタル機器が普及したのは、1983年に発売開始された、フル・デジタル・シンセサイザーYAMAHA DX7の登場後である。このDX7は、サンプリング周波数(60kHz弱)の値により発生するエリアシング・エラー(サンプリング周波数の1/2を境界にスペクトルが反射する現象)のため、高い倍音を含む音を合成しようとすると、DX7ならではの特徴的なサウンドを発生することが知られている。これもデジタル・エラーの典型的かつ古典的な使用例である。

デジタル機器の「エラー時の挙動」は「劣化なきコピー」と並ぶ、デジタル表現の第2の特徴である。そのふるまいは、サンプリング周波数や量子化ビット数、符号化や変調技術の方法、そして記録方式(光学式、機械式、シリコンチップ式…)とその性能などによって決まる。コンピュータという決定論的なシステムのふるまいが、人間に対してしばし予想外の驚きをもたらすのは、ハードウェア~オペレーティング・システム~システム・ソフトウェア~アプリケーションといった、タマネギのように何層にも重なる、もはやその全貌を知りえる人間が存在しないと思えるほどの内部的な複雑さによる。

今日、コンピュータ上の知性や生命の可能性が、いくばくかの現実味をもって議論されているが、それはコンピュータとそれらをつなぐネットワークの複雑さが、人間の認知/理解能力を大きく超えることで、ある種の(人工)自然として捉えざるを得ないためである。自然に対する恐れや畏敬の念と、コンピュータに対する感情的でしばし拒絶的な態度には、何か通じるところがあるのではないか。

[38]電子音楽における失敗(エラー)の重要性について、電子音楽家のキム・カスコーンはThe Aesthetics of Failure(失敗の美学)という論考を執筆しており、邦訳もある。以下、本稿の内容に照らして重要な箇所を引用する。(出典:キム・カスコーン/長壁純子訳「失敗の美学――現代のコンピュータ音楽における「ポスト-デジタル」的傾向」、『ユリイカ 特集=ポスト・ノイズ――越境するサウンド』所収)

この論考で、私は、メディアはもはやメッセージではないということを強調したい。むしろ、特定のツールそのものがメッセージとなっているのだ。(中略)グリッチ、バグ、アプリケーションエラー、システムクラッシュ、クリッピング、エイリアシング、ディストーション、クオンタイズノイズ、さらにはコンピューターのサウンドカードのノイズレベル。作曲家は、こういったものさえも素材として音楽に組み込もうとする。

[39]ジャーゴンとしての「グリッチ(glitch)」には、以下のような意味がある。(出典:https://web.archive.org/web/19991007004557/http://www.netmeg.net/jargon/terms/g/glitch.html)

- 突然、電源の供給、正常性、継続性、プログラム機能が中断すること。復旧可能な場合もある。電源の供給が中断されることを特に「パワー・グリッチ」と呼び、通常はすべてのコンピューターがクラッシュするため、重大な障害となる。専門用語としては、ハッカーが文章の途中まで書いたが、それをどう完成させるつもりだったかを忘れてしまった場合、「ごめん、グリッチしちゃった」と言うことがある。

- 不具合を起こすこと。「gritch」を参照。

- 画面をスクロールすること。WAITS端末では、連続的なスクロールを避けるためにこのような動作をする。

- クッキーと同じ意味(クッキーとは、通信プログラム間で受け渡されるデータのトークンまたは短いパケットのことであり、通常、受信側プログラムにとってそのデータは意味を持たない)。

これらの用法はすべて、この用語が電子ハードウェアの世界で持つ、特定の技術的意味に由来している。グリッチは、回路の入力が変化し、出力が正しい値に落ち着くまでのごく短い間、あるランダムな値に変化するときに発生する。別の回路がちょうど悪いタイミングでこの出力を検出し、ランダムな値を読み取ると、結果が大きく間違っていることがあり、デバッグが非常に困難になる(グリッチは、電子的な特異なバグの多様な原因のひとつである)。

なお、「gritch」の意味は以下。

- 不満(しばしば不具合によって引き起こされる)。

- 文句を言うこと。「グリッチグリッチ」のように動詞が二重になることが多い。

- 「glitch」の同義語。

「gritch」は、「gripe(不満)」と「bitch(愚痴)」の合成語である。「glitch」がまだ厳密にはハードウェア技術者の用語であった1960年代初頭、MITのバートン・ハウス寮では「Gritch Book」と呼ばれる白紙の本があり、住人たちが手書きで苦情や提案、戯言を書き込んでいたという。(出典:https://web.archive.org/web/20000424144407/http://www.netmeg.net/jargon/terms/g/gritch.html)

[40]「エラー」同様にシステム全体の構造や挙動に着目した概念として、サイバネティクスにおける「フィードバック」概念が挙げられる。両者は共に、何か期待される動作や結果と異なる事象が発生することと関連している。しかしエラーの背後にあるのが、偶然やミス、あるいは想定外の外部環境であるのに対し、フィードバックの背後には、想定通りシステムが動いているのにもかかわらず予測できない、非線形性や複雑系、自己組織化や創発の問題が含まれる。

道具から素材へ

道具は人間の手足の延長、あるいは拡張である、というマーシャル・マクルーハンの拡張理論や、人間の知的作業を支援したり増幅する道具としてのコンピュータの開発史を描いた、ハワード・ラインゴールドの『思考のための道具』[41]のように、これまでコンピュータは、人間の手足のみならず、人間の思考や知性を増幅する「メディア」あるいは「道具」とみなされることが多かった。ここでの「メディア」や「道具」には、筆、鉛筆、絵の具、紙、キャンパス、といったオブジェクトのみならず、古くからある電子頭脳という脳のメタファー、あるいはインターネットの出現によって生まれた「サイバースペース」という空間のメタファーも含まれている。

「道具」というメタファーは、「コンピュータなんて、しょせんはただの道具さ」と、コンピュータを神格化する人々に対する抑止力として働いたり、コンピュータを人間にとって複雑すぎる「使いにくい」道具の代表例に祭り上げてきた。一方で、コンピュータ自体を、万能ものまね(メタ)マシン(汎用シミュレータ)として「あらゆる道具になれるマシン」と考える人もいる。

しかし、シミュレーションは結局シミュレーションでしかない。シミュレーションにオリジナルのもつワイルドさや生々しさ(エラーやグリッチ)はない。これだけの複雑さや予測不可能性という可能性を内包したコンピュータを、単なるシミュレーションのための「道具」と呼んでしまって良いのだろうか。一見理論整然としたインターフェースを被せることによって、コンピュータを道具のように見せかけることが可能である。だが、そうすることによって逆に、コンピュータの内側に潜む、豊穰なまでの可能性を覆い隠してしまうことになるのではないか。

むしろコンピュータをいかなるメタファーをも介さずに、コンピュータをコンピュータそのものとして、デジタル表現の「素材」であると捉えてみる。そして、素材としてのコンピュータの特性や、取り扱う手法を知り、素材に導かれながら制作する。

コンピュータの複雑さは、もうひとつの自然である。それは、はさみや包丁といった道具と並べられるよりも、紙や木、金属や石といった(天然)素材と並べられる方がふさわしい。素材としてのデジタル・コンピュータに、メタファーは必要ない。こうした考え方を、僕は「デジタル・マテリアリズム(唯物論)」と呼んでいる。

[41]ハワード・ラインゴールド/日暮雅通訳『新・思考のための道具――知性を拡張するためのテクノロジー その歴史と未来』(パーソナルメディア、2006年)

デジタル・マテリアリズム

表現は素材がもつ様々な特性と深く関連している。マテリアリズムとはすなわち、素材論を追求することでもある。デジタル・マテリアリズムの出発点は、デジタル情報――すなわち「数(digit)」あるいは「数字列」を量的に測定可能なモノとして捉え、その素材としての特性や扱う手法を知ることだ。数が2進数で表されれば、それはビット列になる。空間(かたち)におけるビットマップ表現と座標(ベクトル)表現、色におけるRGB表現、音におけるサンプリング(標本化/量子化/符号化)やDSPといったデジタル表現の基礎知識はいずれも「数」による表現とその操作に根差したものである。

数字列という、デジタル情報を操作するための手法が「アルゴリズム」であり、その具体的な記述が「プログラム」である。「インターフェース」はデジタル情報にアクセスするための手段(インデックス)を提供する。だから、インターフェースにリアリティを持たせようとしても、あまり意味がない。そこにある数字こそがリアリティなのだ。

コンピュータという素材に導かれた表現とは、数という素材の操作アルゴリズムから生まれる表現を、インターフェースを介して人間の様々な知覚と結び付けていく作業である。アルゴリズムのパラメータを変化させることによって、表現はプログラマが想定したある限られた許容範囲内で変奏する。エラーとは、プログラムの内部状態やその表現が、前もって考えられた可能な選択肢以外の、偶然的な状況に逸脱することである。それを「バグ」と呼ぶこともある。アルゴリズムは閉ざされていても、人間というバグの介入が、素材の可能性を開いてゆく。

プログラムをプログラマーが考えなかった選択肢でつかって、

コンピュータがとまってしまうと、それをバグと呼ぶ。

よいプログラム、バグのないプログラムは、

あらゆる段階であらゆる選択肢に対応していなければならない、

とすれば、選択肢はすべて等価、

だれでも使えるが、すべての使い方はすでに予想されている。

ということは、何をやってもおなじこと、

何もやらないことも含めて、すべてが許されている。

選択や決定は、ここでは意味がない。

人間がどちらかを選んで決めることに価値や意味を見いだすということは、

人間はコンピュータから見ればバグでしかない、ということで、

共存はむつかしい。

仮想現実やマン・マシン・インタラクションが

幼稚に見え、しっくりいかないのは、

発展の初期段階だからではなく、

原理的にちがいすぎて、

相互不信と不満が双方にのこるからではないだろうか。[42]

デジタルということばから通常連想されるアナログ信号の「デジタル化」は、非デジタル・マテリアリズム的な概念である。デジタル化、ということばの裏にある「アナログ表現のデジタル近似」という考え方において、デジタル情報は単なる中間表現のひとつにすぎない。そこでは、デジタル情報が持っている様々な特徴の多くは隠蔽され、アナログ表現をいかに正確に近似できるか、ということに焦点があてられがちだ。アナログLP対デジタルCDの音質論争や、アナログカメラ対デジタルカメラの画質論争は、そのよい例である。

[42]高橋、『音楽の反方法論序説』

数と表現

これまで、様々な表現は、映像(イメージ)やサウンド、テキストといったように、表現の形式によって区別されてきた。そしてそれぞれの形式の中に、アナログ/デジタル映像、アナログ/デジタル・サウンド、アナログ/デジタル・テキストと、アナログ表現とデジタル表現の両方があった。

しかしデジタル・マテリアリズムの中心にあるのは、数字列としてのデータだけである。アナログ表現の近似値としての数字列を利用するのではなく、数字列そのものから発想する。世界を数値化するのではなく、数値から世界を創出する。すると、映像やテキスト、サウンドといったこれまでの表現区分は、あくまでも一時的な、かりそめの姿になってしまう。数字列というマテリアルにあるフォーマットをあてはめ、アナログ化することで、それは圧力/物質波としての音波のみならず、色やかたち、テキストなど、様々な形相(eidos)をとりうる。あらゆる数字列から、サウンドを生みだすことも、映像を生みだすことも、テキストを生みだすことも可能である。

たとえば、SoundHack[43]というDSPソフトウェアには、AIFFやWAVといったサウンド・フォーマットで記述されたデジタル・オーディオ情報を再生、処理するだけでなく、どんなファイルでも開いて、それをサウンド表現として再生してしまう機能がある。

また、エドウィン・ハイデとズビグニュー・カルコフスキーによる『データストリーム』(1998)というCD-R[44]では、マイクロソフト・ワード 6.0.1のファイルの数字列を、テキストとしてではなくサウンド/イメージ・データと解釈することで、精妙なノイズ・ミュージックとグラフィックスが作り上げられた。

数字列という素材は、表現形式とは独立である。だからこそ、形式に素材をあてはめるのではなく、素材自体の内的本質を生かしながら、素材と形式の関係を自由にデザインすることができる。「表現形式からの独立」、これが第3の特徴である。

[43]SoundHackは、CalArtsのトム・エルベが1991年に開発を始めた、スペクトラル・オーディオ・プロセッシングのためのソフトウェアである。あらゆるファイルを再生できるだけでなく、ヘッダーのハックなどの独自のユーティリティ、タイムストレッチやピッチシフト、バイノーラル・フィルター、スペクトルによるクロスシンセシス、ノイズ除去、ソノグラムの入出力といった、高度なサウンド処理機能を多数備えていたため(しかもフリーウェア!)、多くのサウンド・アーティストに愛された。現在も、Mac/Win対応のVST/AU/AAXプラグインとして、開発と配布が続いている。

http://www.soundhack.com

[44]本作は1998年オランダで構想・実現し、5時間程の作業でマスタリング、1999年にリリースされた。すべてのオーディオおよびグラフィック素材は、Microsoft Word 6.0.1をデジタル・データ・ソースとして生成されている(マイクロソフト・ワードのファイルにヘッダーを追加してサウンドファイルとして再生する)。音源は以下より聴くことができる。

https://archive.org/details/edwin-van-der-heide–zbigniew-karkowski-datastream

また、以下のサイトに、リリース当時のインタビューとレビューが掲載されている。

https://web.archive.org/web/20000519022551/http://www.touch.demon.co.uk/datastream.htm

量と速度

デジタル表現がもつ「劣化なきコピー」「エラー時の挙動」「表現形式からの独立」という3つの特徴に続く、第4の特徴は「大容量と高速度」である。コンピュータの速度や記憶容量の飛躍的な向上が、サウンド・シンセシス革命をもたらしたように、デジタル表現にとって、その量と速度は本質的である。

「決定的なのは量的な変化である」と語ったのはジョン・ケージだが[45]、コンピュータがもたらした、圧倒的なまでの量と速度は、日常生活における多くの人の想像のはるか彼方にある。デジタル・サウンド・シンセシスは、すべてをサイン波というアトムから構築しようとしたシュトックハウゼンと、非常にたくさんの音を統計的手法によってシンプルにコントロールしようとしたクセナキスとの隔たりを、大量で高速な連続クリック音によって埋めようと試みる。

コンシューマ・プロダクトとしてのApple MacintoshのメインCPUであるPowerPC G4の速度は1ギガフロップスを越え、それゆえPowerMac G4はアメリカ国防相により兵器と認定され、輸出制限を受けた。ハードディスクの容量も標準で10ギガバイトを越える。1ギガフロップスの演算速度とは、1秒間に10億回の浮動小数点演算を行える能力のことである。そして10億分の1秒とは、光が30センチメートル進む距離である。すなわち、PowerPC G4チップは1回の演算を、光が約30センチ進むのと同じ時間で行う。

一方、10ギガバイトの記憶容量は、アルファベット(1バイト)文字で100億個、漢字(2バイト)文字で50億個に相当する。2バイト文字は、原稿用紙相当で1250万枚、500メージの(かなり厚い)本で、約1万冊に相当する。128メガバイトのメモリーですら、約本100冊分に相当する[46]。

人間の想像力や予測可能性をはるかに越えつつも、極限値としての無限や瞬間には至らない中庸の速度や量により、コンピュータはその内側に、豊穰なまでの可能性を含む。一見シンプルな数字列から生み出される、還元論的なシュトックハウゼンと統計論的なクセナキスの中間領域のカオティックな複雑さ――それが素材としてのデジタル・コンピュータが持つ、奥深さと魅力の源泉である。

[45]ジョン・ケージ、ダニエル・シャルル/青山マミ訳『小鳥たちのために』(青土社、1982年)

[46]2020年に発表されたApple M1プロセッサ(システムオンチップ)のクロックは、クロック周波数が最大3.2GHzで、その速度は1テラフロップス近くに達する(なお、2022年には21テラフロップスの速度を誇るM1 Ultraも発表された)。記憶容量に関しても、今ではテラバイトの大きさのHD(ハード・ディスク)やSSD(ソリッド・ステート・ドライブ)が日常的に使用されている。

音楽プログラムの未来

デジタル・コンピュータの高性能化とネットワークの高速化を背景に、今後の音楽プログラムは、高度なスキルを必要とする複雑なインターフェースをもったものから、簡便で誰にでもすぐに使えるオートマティックなものまで、広いベクトルに渡ってますます多様化していくことだろう。同時に、様々なソフトウェアを組み合わせて使うブリコラージュの方法も、ますます盛んになるだろう。

インターフェースという観点から興味深いのは、Communications of the ACM(Association for Computing Machinery, Inc.)の、 1996年8月号に掲載された「アンチ=マック・インターフェース」という記事である[47]。著者のドン・ゲントナーとヤコブ・ニールセンはこの記事で、今日のGUIデザインの原典とみなされている「マッキントッシュ・ヒューマン・インターフェース・ガイドライン」[48]をベースに、あえてその原則に反するインターフェースを考察した。ゲントナーとニールセン自身は、こうした考察を、インターフェースの可能性を拡げるための一種の思考実験として行ったと述べているが、それだけでなく、ここには今後起こりうるコンピュータと人間の新しい関係に関する、いくつかの洞察と兆しが含まれている。

1984年、マッキントッシュが登場した当時のインターフェース・デザインの前提となるパーソナル・コンピュータの能力は、以下のようなものであった。

- ほとんどのユーザーがコンピュータとそのGUIに初めて触れた。

- アプリケーションの種類や数が少なかった。

- コンピュータの速度や記憶容量がきわめて小さかった(クロック8MHzの68000CPUと、128KBのメモリー、ハードディスクはなく、400KBのフロッピーのみ接続)。

- コンピュータの表示能力が低く(モノクロ9インチディスプレイに低音質のオーディオ)、入力装置もキーボードと1ボタンマウスに限られていた。

- ネットワークが普及しておらず、スタンドアローンのマシンがほとんどであった。

しかし今や、子供のころからゲームマシンを通じてコンピュータに接しているユーザーが使用し、常に変化し続けるインターネットに接続された、ギガフロップスクラスのパーソナル・マシンの時代である。ディスプレイも大型化、高解像度化すると同時に、マウスやキーボードだけでなく、視覚や聴覚、触覚や嗅覚それぞれの特性や脳波などの生体信号を生かしたインターフェース・デバイスも登場し始めている。マッキントッシュのモットーである、WYSIWYG(What You See Is What YouGet、見たままが得られる)も、それがWYSIATI(What You See Is All There Is、見えるものしかない)であるだけに、今やむしろ逆に、制限となることが多い。

彼らの言う、アンチ=マック・インターフェースとは、ポストGUI・インターフェースのことでもある。そのポイントをまとめると、以下のようになる。

- 直接操作から操作の委譲へ。細かいところはシステムにまかせる。

- 豊かな内部表現を持ち、相互作用する自律オブジェクト(エージェント)を利用する。

- 検索から配達へ。情報がユーザーのもとにやってくる。

- 一貫性から、量と速度をもった多様性へ。

- 見たまま(アフォーダンス)より意味(セマンティクス)の重視。

- 言語(説明とコマンド)の重要性の再確認。

- 経験豊富なエキスパートユーザーを対象にする。

- ユーザーの行動をモデルにする(インターフェースからインタラクションへ)。

- より多彩でリアルな表現のインターフェース。

- コンピュータの操作を共有し、他のユーザーと協力しながら行う。

こうしたインターフェースの変化の可能性は、当然のことながら、音楽プログラムにもあてはまる。むしろGUIという、必ずしもリアルタイム・パフォーマンスに適しているとはいえないタイプのインターフェースをこれからどう乗り越えて行くのかが、音楽プログラムの未来の鍵を握っている。

たとえば、ネトチカ・ネズバノヴのデザインによるリアルタイムDSP+ノンリニア・プレイバック・エンジン、b1257+12は、ドット単位のオペレーションが必要なほどに巧緻化されたインターフェースを持つ[49]。

同じくネトチカによるnebula.m81.0+2[50]は、あらゆるデジタルデータを自律的かつ断続的にインターネット経由でダウンロードし、サウンドやイメージに変換する、Javaで記述されたプログラムである。デジタル表現のもつ「表現形式からの独立」という第3の特徴が、いち早くインプリメントされていると同時に、周波数/時間領域双方での(クロス・)シンセシスやグラニューラ・シンセシスといったサウンド・プロセッシングの機能も有している。

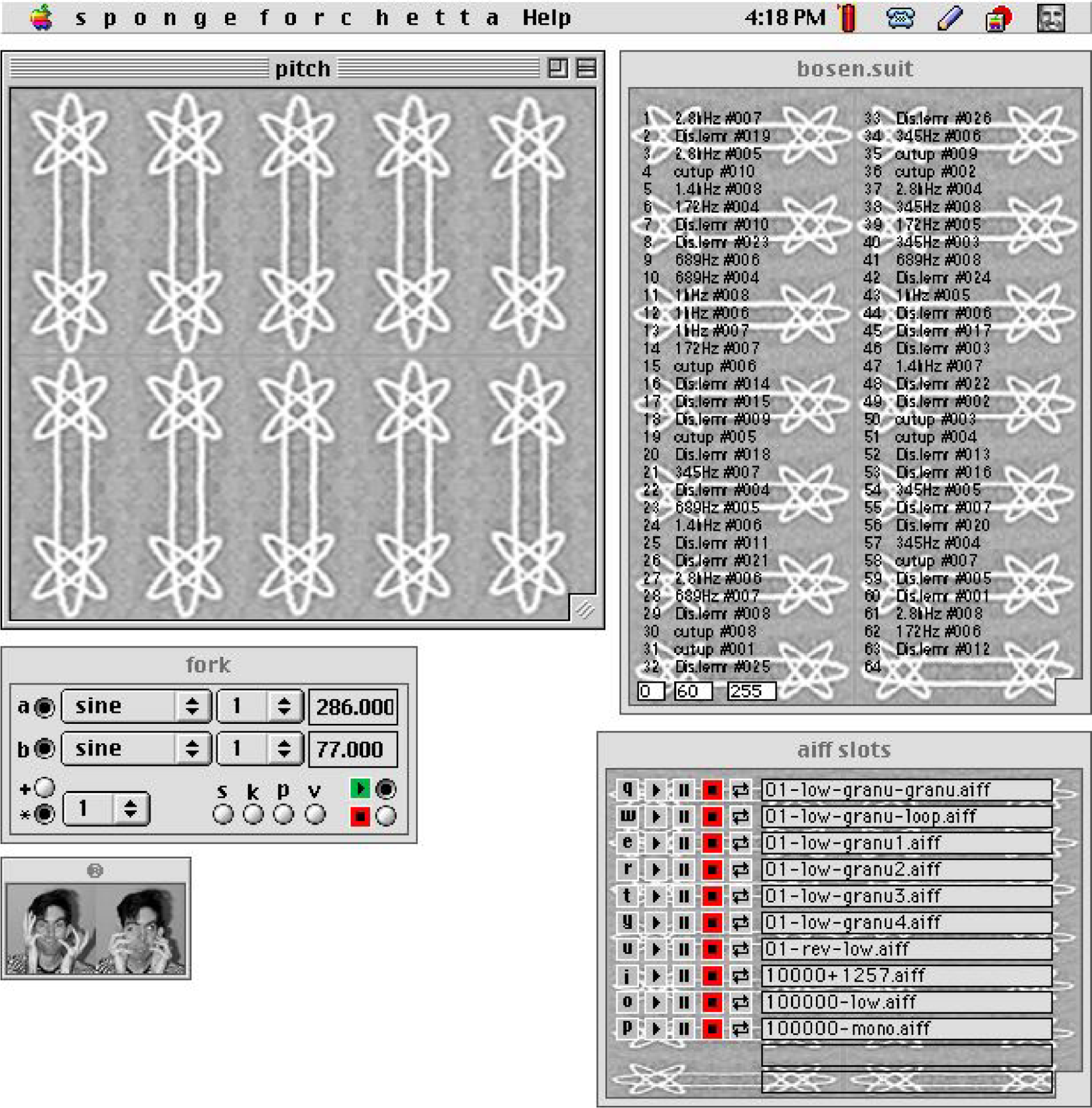

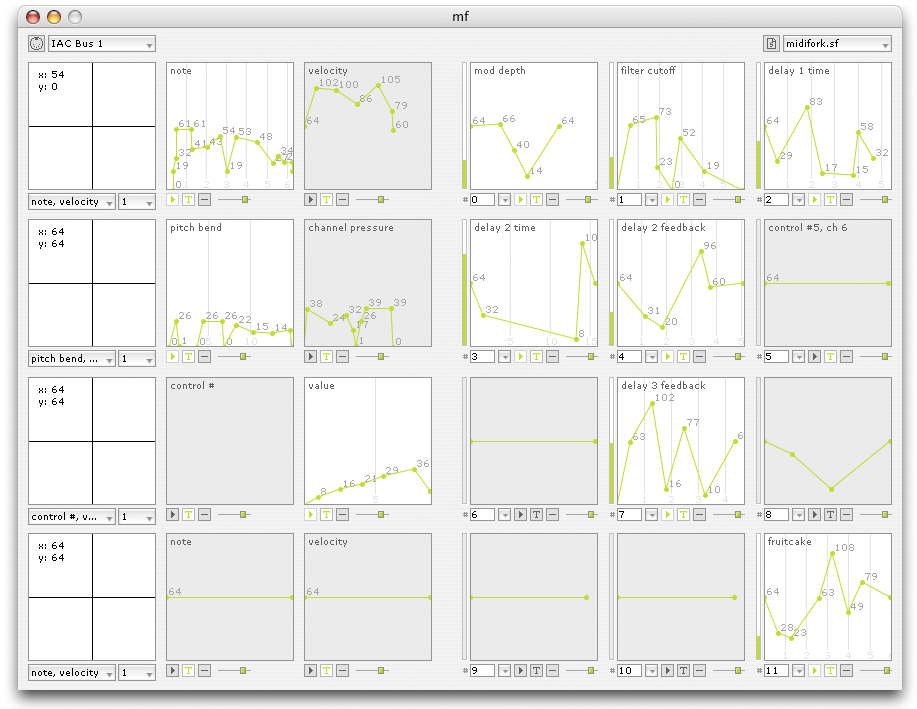

1999年に行われた4th international musical software competitionで、ソフトウェア・シンセシス/リアルタイム・プロセッシング部門のグランプリに輝いたリアン・フランシスコーニによるSpongefork[51]は、ライブ・パフォーマンスのためにデザインされた、コンパクトかつ柔軟性の高いプログラムである。Spongeforkはサンプルファイルの再生も可能な2つのオシレータと、最大64のサウンドファイルを、キーボード・ショートカットとマウスの動きのコンビネーションで操作できる。キー・コンビネーションやマウスの動きとサウンドの関係は、b1257+12のように一見込み入っているが、それだけに奥の深い、身体的な演奏が可能になる。

アキラ・ラブレーによるDSPプログラム、Argeïphontes Lyre[52]は、ノン・リアルタイムではあるものの、ミステリアスで詩的なインターフェースがユーザーの想像力を刺激する。「内臓摘出蘇生器(Eviscerator Reanimator)」と題された、複数のサウンドファイルを小さなチャンクに分解してから、それを1つのファイルに再構成するというメインのDSP機能は、人間の知覚的体制化(心理的群化)や聴覚的補完現象とも深くかかわっている。

Audio Easeのグラニューラ・シンセシス・ソフト、thOnk_0+2[53]は、通常たくさんのパラメータの調節が必要なグラニューラ・シンセシスに対して、逆にそのパラメータを自律的に変化させることで、ユーザーが元になるファイルを指定した後、まったくコントロールなしに多様なサウンドを自動生成する(インターフェースは、ネトチカのデザインによる)。

これらのプログラムは「多様性」「複雑性」「自律性」といった、これからのインターフェースが持つべき機能のいくつかをすでに実現している。今日のクリエイティブなソフトウェアが、多様で複雑であることは、むしろ普通のことである。リアルタイム・シンセシス革命に続くであろう、インターフェースのブレイクスルーも、もう目前に迫っている。

[47]Don Gentner, Jakob Nielsen “The Anti-Mac interface”(1996)

https://dl.acm.org/doi/10.1145/232014.232032

[48]現在ではマッキントッシュの冠を廃し、アップル製品一般の「Human Interface Guidelines」として公開中。2023年には史上初となる公式の日本語版も公開された。

https://developer.apple.com/jp/design/human-interface-guidelines/

[49]b1257+12は、サードパーティのDSPカードを必要とせず、パワー・マッキントッシュでデジタル・スクラブを可能にした。ソフトウェアベースのターンテーブル・スタイルのスクラッチ+グラニュレーション環境を提供した、初めてのアプリケーションだった。

https://web.archive.org/web/20051223192400/http://www.m9ndfukc.org/korporat/kode_macintosh.html

b1257+12のインターフェース

[50]nebula.m81.0+2の実装例として、kinematek 0+2がある。これは自律型ネットボット、アスキーフィルムプログラム、データ制御画像生成プログラム、オーディオプログラムの組み合わせからなる、インターネット(WWW)データからのアニメーション画像生成を実行するアプリケーションである。

https://web.archive.org/web/20051218233016/http://www.m9ndfukc.org:80/korporat/kode_multiplatform.html

kinematek 0+2のインターフェース

[51]Spongeforkは、キーボード・ショートカットとテルミンのようなマウス動作を組み合わせた、コックピット型のインターフェイスによるプレイバック・エンジン。ヴァージョン1は、CalArts(カルフォルニア芸術大学)のプログラマー/ミュージシャンのライアン・フランチェスコーニによって作られた。Mac OS 9が終了した後も、OS X上で動くヴァージョン3まで開発された。

https://web.archive.org/web/20210508172141/http://spongefork.com/

Spongefork ヴァージョン1のインターフェース

Spongefork ヴァージョン2のインターフェース

Spongefork ヴァージョン3のインターフェース

[52]Argeïphontes Lyreの最初のヴァージョンは1998年、カリフォルニア芸術大学でトム・エルベに学んだアキラ・ラブレーの修士課程の終了制作として作られた。ディストーション、グラニュレーション、FMシンセシス、そしてラリー・ポランスキー博士の研究に基づいたタイムドメイン・ミューテーションのヴァージョンのフィルターが搭載されていた。

その後ラブレーは、ディズニーとユニバーサルで働き、ミューテーションの改良、さらに多くのディストーションのテクニック、そしてタイムドメイン・コンボリューションに初挑戦したヴァージョン2をリリースする。アプリケーションは現在もメンテナンスされていて、以下のページから最初のヴァージョン~最新のヴァージョン6まですべてダウンロードが可能である。

https://akirarabelais.com/al/

Argeïphontes Lyre ヴァージョン2のインターフェース

[53]thOnk_0+2は、作曲家がライターズ・ブロック(作家が新しい作品を生み出す能力を失ったり、創作上の低迷を経験したりする状態)から抜け出すために、何も考えることなく、新鮮で予想外な素材を手に入れるための「音の宝箱」を提供する。マッキントッシュのフリーウェア・アプリケーションであり、使い方は非常に簡単……というか、ほとんど何もしなくていい。グラニュラーシンセシスを使い、ユーザーが提供したサウンドファイルに基づいて、「全く操作なしに」非常に多様なサウンドを生成する。

https://web.archive.org/web/20101119153329/http://audioease.com/Pages/Legacy/

thOnk_0+2のインターフェース

人間から遠くはなれて

冒頭にあげた「電子音楽の120年」旧ヴァージョンの「未来」のセクションには、1980年代のデジタル・シンセサイザーの発展に続く、90年代の電子音楽のキー・イッシューのひとつとして「超低音と超音波(超高音)」があげられていた。

「超低音」とは人間の可聴音域を下回る、20Hz以下の振動のことである。それは10~40Hz程度の周波数を持つ脳波[54]や、同じく立位で3~6Hz程度の人体の振動特性とオーバーラップしてくるため、低周波公害のように、気が付かないうちに人間の体に影響を与える。120BPMに相当する2Hzの振動から人間の可聴域の下限である20Hzまでの領域には、脳波や骨格の固有振動数などが含まれ、リズムと音が隔てられる、人間の知覚のグレーゾーンである。

可聴域以上、つまり20000Hz以上の「超音波」に関しては、オーディオ音質的な要請で、サンプリング周波数を高くすることやスーパー・トゥイータの使用で対応されつつあるが[55]、超低周波の音は、DAコンバータの性能や、再生装置の巨大化の限界[56]から、今なお困難である。最近のポピュラー・ミュージックやクラブ・ミュージックには、20~30Hzの音まで含まれているといわれるが、それでもここで着目している超低音域には届かない。

ポスト・テクノ(ロジー)・ミュージックに「(生)録音」というプロセスや「(原音)再生」という概念はない。制作のみならず、パッケージや配信を含め、すべての操作や処理がコンピュータ上のデジタル・ドメインで行われ、そこで数字列としての音が生成される。生か録音か、という音楽/オーディオにおける従来の二項対立は存在しない。

その最後のボトルネックは人間の耳である。生身の人間の耳や体はデジタルではないがゆえ、数字列としての音を聴取するためには、なんらかのオーディオ装置を用いて、デジタル信号を物質(聴覚神経に直接接続する場合は電気)的振動に変換(アナログ化)する必要がある。

人間の可聴領域、さらに全身の知覚をフルに活用してその可能性を拡げるためには、この変換装置の性能が体験に大きな影響を与える。コマーシャルなポピュラー音楽は、安価で低音量のオーディオ装置でも楽しめるように、機器の性能にあまり影響されない音づくりをめざしているが、ポスト・テクノ(ロジー)・ミュージックの体験は、オーディオ装置の能力や特性に強く依存している。ピタやヘッカー、オヴァルの音楽は再生装置の構造やそのセッティング、音量によって、聴こえ方が大きく変わってくる。オーディオ装置は数字列から物理的な音場を形成する、ポスト・テクノ(ロジー)時代の楽器である[57]。

シュトックハウゼンの「統一された時間構造」にもとづいた、凡周波数的な音楽作品を制作するためには、リズムと音のグレーゾーンを埋める「超低周波、もしくは超高速リズム生成装置」という楽器の開発が必要不可欠である。「コンタクテ」の17分5秒の部分の表現は手強い[58]。

超低音/超音波の可能性にせよ、ポストGUIのインターフェースにせよ、そこには、非日常の困難な状況に対しても、あえて自らを変化させて対応する、人間の能力のダイナミズムに対する深い信頼がある。「人にやさしい」という耳触りの良いキャッチフレーズと共に、人間中心のデザインの必要性が語られはじめて久しい。しかし人間中心の、誰にでもすぐに使えるツールの裏側には、自らを変化させることができる人間の能力を矮小化した、人間不信の考え方が潜んでいる。

人間を信じることとは、人を過去のパターンや既成の概念に当てはめることではなく、その驚くほどの可能性や柔軟性を信じることだ。不動点を意味する中心のメタファーではなく、人間を常に変化しうる動的かつ周縁的な存在として捉えることだ。

コンピュータの扱いにくさに対して不平をいう人は多い。しかし、石や金属といった素材に対して、人にやさしいかどうかを考えたり、「人間中心!」と叫ぶ人はいない。素材の本性や、そこから導かれた表現の形式が人間から遠くはなれていたとしても、その遠さこそが、生活の豊かさや新たな創造の原動力になる。振り返れば、エリシャ・グレイの音楽電信機やタデアス・カイルのテルハーモニウムに始まる電子音楽の歴史にも、そうした人間自身に対する深い信頼が感じられる。

パーソナルなサウンド・シンセシス/DSP革命とその拡散は、アカデミズム、インダストリアル・ノイズ、テクノ、アンビエントといった諸々の音楽ジャンルの枠組みを越えて同時に起こり、それゆえ既存のジャンル、さらには「音楽」という概念を超えたデジタリズムとも呼ぶべきメタ・カルチャーを生み出した。ここで提示したデジタル表現の4つの特徴、

- 劣化なきコピー

- エラー時の挙動

- 表現形式からの独立

- 大容量と高速度

が、そうした時代の制作/表現や文化を、背後から、かたちづくっている。

[54]人間の脳波の周波数は、β波(意識)=18~40Hz、α波(弛緩)=8~12Hz、Θ波(創造)=4~7Hz、δ波(睡眠)=1~3Hzである。

[55]DVDオーディオ規格のサンプリング周波数は、48/96/192kHz(あるいは44.1/88.2/176.4kHz)で、量子化ビット数も16/20/24ビットである。これは理論的再生可能周波数が96kHzで、ダイナミックレンジが144dBであるということを示している。

今日「ハイレゾ」と呼ばれる、高音質のコーデック(符号化方式)には、リニアPCM(パルス符号変調)とそのロスレス(可逆)圧縮だけでなく、PDM(パルス密度変調)を用いたDSD(Direct Stream Digital)や、一般的なCDにハイレゾ音源を格納することができる、MQA(Master Quality Authenticated)エンコードなどもある。DSDの量子化ビット数は1ビットで、そのサンプリング周波数は、DSD512の場合22.4MHzである。

[56]イタリアのRoyal Device社が開発した、世界最大の家庭用サブウーファーとされる「Real Total Horn」は、床下に埋め込まれた長さ9.5メートル、深さ1mのホーンが、合計16個の47cmウーファーで駆動するというものである。アンプの電力出力よりも、スピーカーの出力能力に重点を置いており、リスニングポジションを中心に10Hz以下からの音を再生することができる。

http://www.royaldevice.com/sala-audio-royaldevice.html

[57]小杉武久『音楽のピクニック』(書肆風の薔薇、1991年)によれば、かつてカリフォルニアのバイオームというグループが「もしコンサート・ピアニストがよく調律されたグランド・ピアノを期待する歴史的な権利があるとするなら、二十世紀後半の音楽家たちは必要にして充分なラウドスピーカを期待する権利がある」と主張したという。「ユーザーの設定によって、最終的な表現が確定する」というデジタル・サウンドとオーディオ装置の関係は、HTMLファイルとブラウザの関係にも似ている。DTPからウェブへの変化がエディトリアル/グラフィック・デザイナーに大きな戸惑いとアプローチの修正をもたらしたように、マスタリングや再生装置のプロセスをリスナーに委ねることで、音楽制作のワークフローは大きく変化する。

[58]以下の動画で、音色がリズムに連続的に移行していく「コンタクテ」の17分5秒の部分をスコアとともに聴くことができる。

https://youtu.be/l_UHaulsw3M?t=1039

ちなみに、「コンタクテ」の17分5秒の部分に似た高速リズムと矩形低周波の境界領域の横断が多用されているのが、トーマス・ジェンキンソンことスクエアプッシャーの2枚目のソロアルバム『Hard Normal Daddy』(1997)である。特に収録楽曲「Beep Street」で顕著に聴き取れる。

https://www.youtube.com/watch?v=LKJ-0ZO4pxo